Wie hört ein Mensch? Wie unterscheidet er zwischen Lauten und gesprochenem Wort? In der Sprache gibt es zwei Unterscheidungsmerkmale: die Stimme des Sprechers und den sprachlichen Inhalt selbst, einschließlich der Sprachlaute. Forscher der Universität Genf (UNIGE) und der Universität Maastricht haben nun gezeigt, dass sich das Gehirn, der auditorische Kortex, daran anpasst, was ein Mensch hören will. Es konzentriert sich entweder auf die Stimme eines Sprechers oder auf die gesprochenen Sprachlaute.

Um herauszufinden, wie diese zerebralen Mechanismen der Sprachverarbeitung funktionieren, entwickelten die Forscher Pseudowörter, also Wörter ohne Bedeutung, die von drei Stimmen mit unterschiedlichen Stimmlagen gesprochen wurden. Sie wollten sehen, wie das Gehirn diese Informationen verarbeitet, wenn es sich entweder auf die Stimme oder auf die Sprachlaute konzentriert. Dabei entdeckten sie, dass der auditorische Kortex verschiedene Aspekte der Geräusche verstärkt, je nachdem, welches Ziel verfolgt wird. Für die Unterscheidung von Stimmen werden dabei in erster Linie Stimmenspezifische Informationen verarbeitet, während phonemspezifische Informationen für die Differenzierung von Sprachlauten wichtig sind.

Pseudowörter

„Wir haben 120 Pseudowörter erstellt, die der Phonologie der französischen Sprache entsprechen, aber keinen Sinn ergeben, um sicherzustellen, dass die semantische Verarbeitung die reine Wahrnehmung der Phoneme nicht beeinträchtigt”, erklärt Narly Golestani, Professorin in der Psychologieabteilung der Fakultät für Psychologie und Erziehungswissenschaften (FPSE) der UNIGE. Diese Pseudowörter enthielten alle Phoneme wie /p/, /t/t/ oder /k/, wie in /preperibion/, /gabratade/ und /ecalimacre/.

Gesprochen wurden die Pseudowörter von einer Phonetikerin. Anschließend wandelten die Wissenschaftler die Stimme in verschiedene, tiefere und höhere Stimmen um. „Um die Differenzierung der Stimmen ebenso schwierig zu machen wie die Differenzierung der Sprachlaute, haben wir die aufgezeichneten Stimuli so geändert, dass sie wie drei verschiedene Stimmen erschienen, anstatt sie tatsächlich von drei verschiedene Menschen aufzunehmen”, erklärt Sanne Rutten, Forscherin an der Psychologieabteilung des FÖDÜ der UNIGE.

„Spektrale Modulationen“

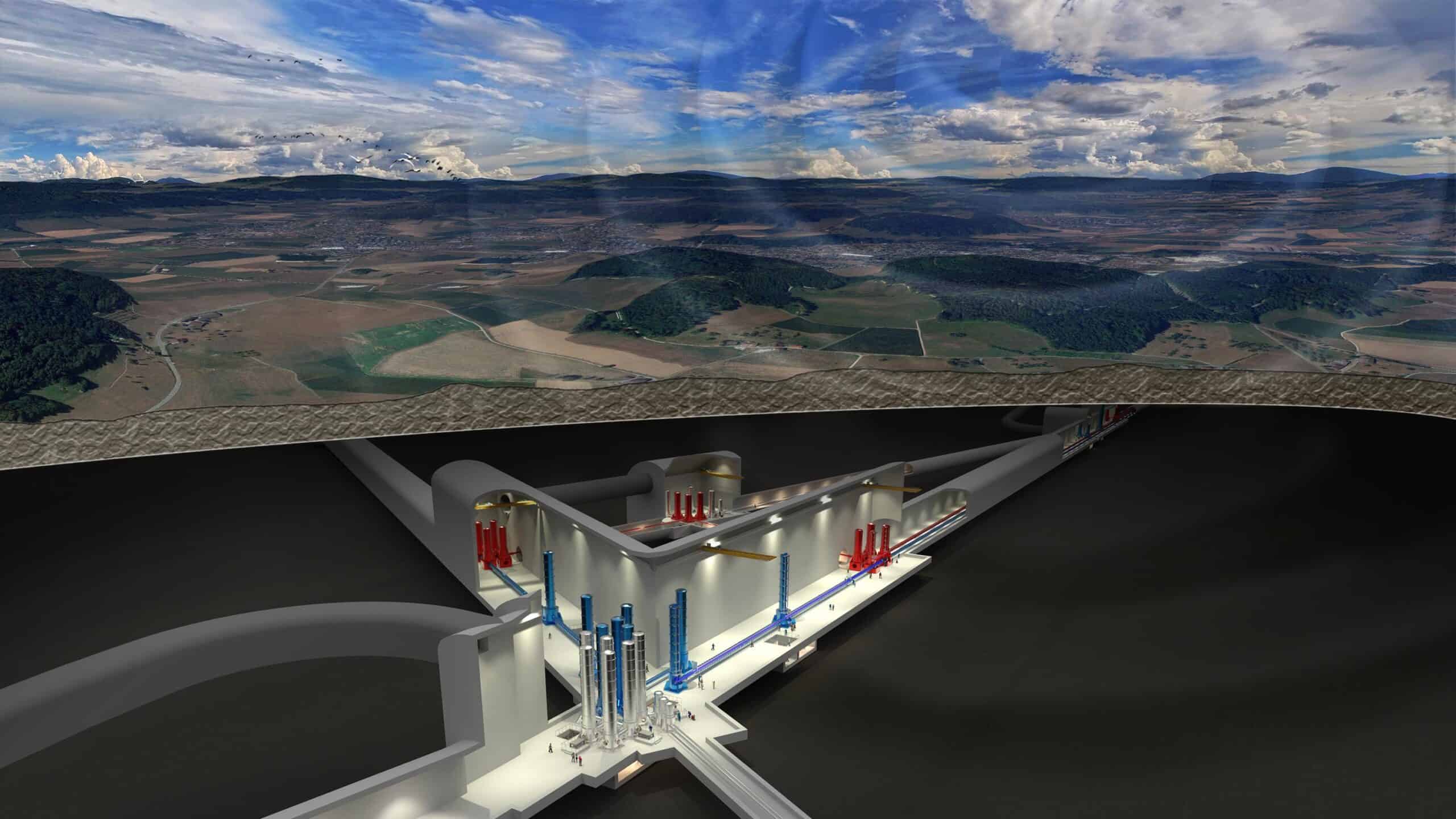

Während der Studie zeichneten die Forscher die Gehirnaktivitäten der Versuchspersonen mit der funktionellen Magnetresonanztomographie (fMRI) bei hohem Magnetfeld (7 Tesla) auf. Mit dieser Methode kann man die Gehirnaktivität beobachten, indem man die Sauerstoffversorgung des Blutes im Gehirn misst: Je mehr Sauerstoff benötigt wird, desto mehr wird dieser bestimmte Bereich des Gehirns genutzt.

Beim Scannen hörten die Teilnehmer in einer Sitzung die Pseudowörter und sollten die Phoneme /p/,/t/t/ oder /k/ identifizieren. In einer anderen Sitzung sollten sie sagen, ob die Pseudowörter von Stimme 1, 2 oder 3 gelesen wurden. Bei der Auswertung analysierten die Wissenschaftler dann zunächst die Pseudowörter. Sie untersuchten Unterschiede in der Frequenz (hoch / niedrig), der zeitlichen Modulation (wie schnell sich die Klänge im Laufe der Zeit ändern) und der spektralen Modulation (wie die Energie auf verschiedene Frequenzen verteilt ist). Dabei fanden sie heraus, dass hohe spektrale Modulationen die Stimmen am besten differenzierten. Schnelle zeitliche Modulationen gepaart mit niedrigen spektralen Modulationen differenzierten dagegen die Phoneme am besten.

Unterschiedliche Reaktionen des Gehirns

Im nächsten Schritt analysierten die Forscher mit Hilfe von Computermodellen die fMRI-Reaktionen, d.h. die Gehirnaktivität im auditorischen Kortex währen das Gehirn die Geräusche während der beiden Aufgaben verarbeitete. „Die Ergebnisse zeigen große Ähnlichkeiten zwischen den Aufgabeninformationen in den Klängen selbst und den neuronalen, fMRI-Daten”, sagt Golestani. Genau gesagt heiße das, dass der auditorische Kortex die höheren spektralen Modulationen verstärkte, als die Teilnehmer sich auf die Stimmen konzentrieren mussten. Bei den Phonemen habe der der Kortex dagegen mehr auf die schnellen zeitlichen Modulationen und auf die niedrigen spektralen Modulationen reagiert.

„Es ist das erste Mal, dass beim Menschen und mit nicht-invasiven Methoden gezeigt wird, dass sich das Gehirn an die jeweilige Aufgabe anpasst, und zwar in einer Weise, die mit den akustischen Informationen übereinstimmt, die in Sprachlauten verarbeitet werden”, betont Sanne Rutten. „Das wird für unsere zukünftige Forschung nützlich sein, insbesondere bei der Verarbeitung anderer Sprachebenen – darunter Semantik, Syntax und Prosodie -, Themen, die wir im Rahmen eines Nationalen Forschungsschwerpunkts über die Herkunft und Zukunft der Sprache untersuchen wollen.”

Die Ergebnisse der Studie wurden in der Zeitschrift Nature Human Behaviour veröffentlicht.

Mehr Artikel zum Thema Gehirn gibt es hier