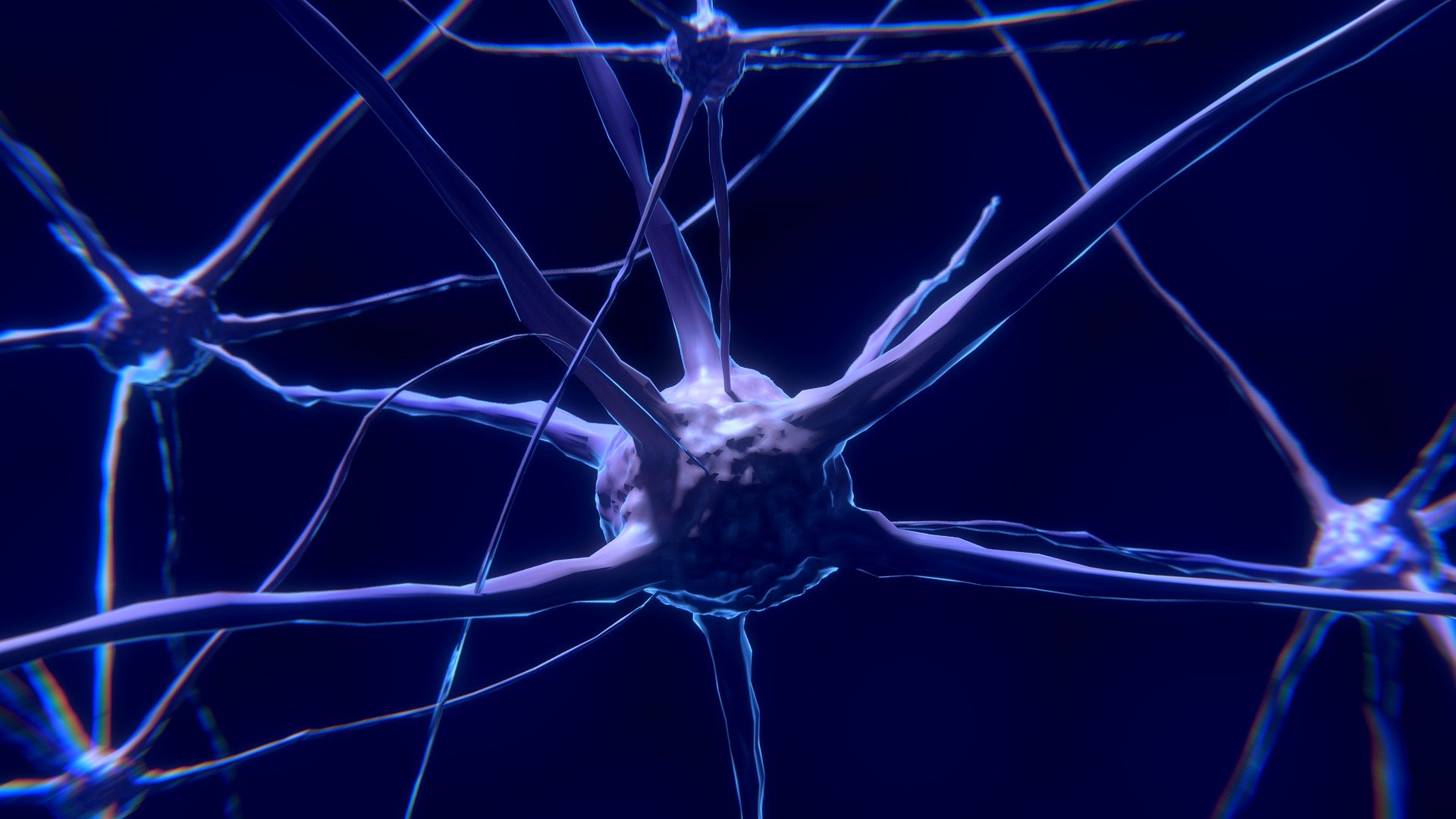

Der Neuro-Informatiker Wolfgang Maass forscht seit 20 Jahren am Institut für Grundlagen der Informationsverarbeitung an der TU Graz. Hier sucht er nach einem konzeptionellen Rahmen und algorithmischen Methoden für ein Gehirn Modell der Maus. Sein besonderes Interesse gilt energie-effizienten Konzepten wie diese im biologischen Gehirn zu beobachten sind. Die datenbasierte Modellierung bestimmter Funktionen im Mausgehirn war ihm schon in der Vergangenheit möglich. Jetzt gelang es ihm und seinen Postdocs Chen Guozhang und Franz Scherr erstmals ein detailliertes Großmodell des Gehirns der Maus zu trainieren und darin auch die Funktion des Sehens auszuführen.

Sehfunktion in der Künstlichen Intelligenz

Die Sehfunktion ist in der Informatik insofern von Interesse, als sie eine der zentralen Funktionen in der Künstlichen Intelligenz ist. Das zeigen Beispiele wie das autonome Fahren und die Bildverarbeitung. Hierbei werden Daten aus der Umgebung via Sensoren erfasst und an entsprechend trainierte Algorithmen weitergeleitet. Diese interpretieren diese Daten – und lernen daraus.

Entschlüsselung des visuellen Cortex

Dass die Forscher in ihrem datenbasierten Gehirn Modell nun auch bestimmte Sehfunktionen gezielt ausführen können, liegt an den Errungenschaften des renommierten Allen Institute for Brain Science in Seattle. Dieses widmet sich unter anderem der Entschlüsselung des visuellen Cortex von Mäusen und machte die entscheidenden Daten zuletzt öffentlich. „Damit haben wir erstmals die Daten bekommen, mit denen wir unser allgemeines Know-how mit Leben füllen konnten“, sagt Maass.

Trainieren biologischer Neuronen

Die Daten des Allen Instituts lieferten ein wertvolles Gerüst für das biologische visuelle Netzwerk, aber es war ein Gerüst mit einer enormen Menge an Lücken. Denn das Wissen von neuronalen Netzwerken befindet sich in den Gewichten von synaptischen Verbindungen zwischen den Neuronen, die kaum messbar sind. Die Forscher wendeten Maschinelles Lernen an, um die fehlenden biologischen Daten mit mathematischer Optimierung zu ersetzen. Allerdings lassen sich neurologische Netzwerke, die nahe an der Biologie sind, nicht so leicht trainieren. „Biologische Neuronen haben eine unstetige Arbeitsweise. Anders als künstliche Neuronen senden sie Aktionspotenziale aus – und nicht einen sich langsam verändernden Wert. Dadurch kann das Gradientenverfahren nicht angewendet werden, das in der Numerik eingesetzt wird, um allgemeine Optimierungsprobleme zu lösen“, erklärt Professor Maass. Beim Gradientenverfahren schreitet man von einem Startpunkt aus entlang einer Abstiegsrichtung, bis keine numerische Verbesserung mehr erzielt wird.

Gehirnähnliche Sehleistung

Auf Basis der Daten des Allen Instituts und ihrer eigenen Software entwickelten die Forscher ein detailliertes biologisches Großmodell des primären visuellen Kortex der Maus. Die Ergebnisse der am Jülich Supercomputing Centre durchgeführten Tests zeigten, dass das neuartige Gehirn Modell mehrere visuelle Verarbeitungsaufgaben lösen kann. Zum Beispiel kann es Bilder von handgeschriebenen Zahlen klassifizieren oder visuelle Veränderungen in einer langen Bildsequenz erkennen. Das virtuelle Gehirn Modell arbeitete mit hoher Genauigkeit und erreichte eine Leistung, die mit jener des Gehirns der Maus vergleichbar ist – selbst dann, wenn es einem Rauschen in den Bildern und im Netzwerk ausgesetzt war, dem es beim Training nicht begegnet war. Bei eben dieser Robustheit gegen Störungen im Bild oder im Netzwerk ist das biologische Modell den gängigen Modellen für die visuelle Verarbeitung in der KI überlegen. Ein Fakt, den die Forscher damit erklären, dass ihr Modell mehrere charakteristische Kodierungseigenschaften des Gehirns nachbildet.

Die Forscher verwendeten einen Standardtest für künstliche neuronale Netzwerke. Jedoch können vier der Tests, für die das Modell trainiert wurde, auch von der Maus gelernt werden. Zum Beispiel kann die Maus visuelle Veränderungen in einer langen Bildsequenz erkennen. Daher kann das Team die Leistung der Maus mit seinem Modell vergleichen.

Neuronale Netzen in der KI

Wobei es immer noch sein könne, dass das Sehen bei der Maus anders funktioniere. Denn grundsätzlich sind Biologie und Künstliche Intelligenz zwei verschiedene Ansätze zur Erreichung visueller Funktionen in neuronalen Netzwerken. Bei der Analyse ihres neuartigen Gehirn Modells haben die Forscher beides gefunden: Merkmale, die mit Befunden von biologischen Experimenten übereinstimmen, aber auch Merkmale, die sich von diesen unterscheiden. „Weshalb KI-basierte Modelle nur sehr beschränkt auf die Sehfunktion im Gehirn schließen lassen, erklärt Maass – und weiter: „Unser Papier ist eines der ersten, das versucht, diese Verzweigung in Biologie und KI klar darzustellen.“

Geringer Energieverbrauch

„Einige dieser Kodierungseigenschaften des biologischen Gehirns würde man sich in der KI gern abschauen“, so der Forscher. Wie etwa die sogenannte sparse activity der Neuronen, die im Gros meistens inaktiv sind – und dadurch auch keine Energie verbrauchen. Möglich wird dies durch die sogenannte Mixture of Experts. Das sind lokale Netzwerke im Gehirn, die in ihrer Kompetenz spezialisiert sind. Sie bestehen aus Experten, die nur dann reagieren, wenn sie wirklich etwas zur Lösung der Aufgabe beizutragen haben.

Hingegen sind die Neuronen in den neuronalen künstlichen Netzwerken im Maschinellen Lernen fast sämtlich und durchgehend aktiv und verbrauchen dabei enorm viel Strom. Insofern seien viele Bereiche der Industrie daran interessiert, neue Zugänge zu finden und der biologische Prototyp der Grazer Forscher könnte neue Designs inspirieren, so Maass.

Ein Standardwert

Das Gehirn Modell der Grazer Forscher bietet die Möglichkeit, eine Hypothese zu implementieren – und zeigt, wie die Computation in dem Modell organisiert ist, wie sie abläuft und was das Modell unter bestimmten Umständen leisten kann. Als solches bildet es einen Standardwert, mit dem auch viele andere aus der Biologie kommende Modelle getestet und verglichen werden können. Um den Energieverbrauch der Neuronen aus künstlichen und biologischen neuronalen Netzwerken zu vergleichen, implementieren die Forscher das Gehirn Modell gerade auf einem Chip von Intel, welcher der Forschung zugänglich werden soll.

Technische Errungenschaften der KI

Dass die Forscher das Gehirn der Maus so detailliert modellieren und die Funktion des Sehens nachbilden konnten, ist nicht zuletzt den enormen technischen Errungenschaften der Künstlichen Intelligenz der vergangenen Jahre zu verdanken. Bis zuletzt bildeten sich die zwei Zugänge zu neuronalen Netzen auch in der Software ab. Das heißt, es gab zwei Arten von Software:

Software im Maschinellen Lernen, die von TensorFlow und PyTorch entwickelt wurden und die auf Graphikprozessoren (GPU’s) lief.

Software, die geeignet war, biologische Modelle zu simulieren – ohne dass diese noch eine Funktion hatten.

Schnelle GPU‘s mit hoher Speicherkraft

Als die Forscher die von ihnen modellierte Sehfunktion im Gehirn der Maus am Supercomputer in Jülich testeten, hatte man dort gerade eine neue Generation Graphikprozessoren von Nvidia bekommen. Diese zeichnen sich durch hohe Geschwindigkeit und Speicherfähigkeit aus. Das war insofern erforderlich, als das Trainieren des neuartigen Modells sehr schnelle Simulationen erfordert und dass es circa 100.000-mal simuliert werden muss – jeweils mit anderen Werten von Gewichten.

Die leistungsfähigere Technologie ermöglichte den Grazer Forschern die verschiedenen Software-Konzepte zusammenzubringen und zu zeigen, dass man auch die biologischen Modelle auf TensorFlow simulieren – und sehr effizient trainieren kann. Eine Innovation, die der KI-Industrie unerwartet eine Nebenschiene bringe, so Maass. Denn diese könne Tools, Software und Hardware der KI-orientierten Industrie fortan auch für die Hirnforschung nutzen.

Sehfunktion im autonomen Fahren

Wenn Technologieunternehmen wie Intel und IBM an alternativen Methoden des Sehens auf Chips arbeiten, dann liege der Fokus auf Energieeffizienz und Intelligenz, die man ins Sehen integrieren wolle, weiß Maass. Die Sehfunktion in KI-Systemen basiert auf bottom-up Informationen. Das heißt, die Kamera liefert Pixelinformationen, die in der Verarbeitung immer abstrakter werden. Das Gehirn agiert anders. Es verbindet die Informationen vom Auge sehr rasch mit top-down-Informationen. Das sind erfahrungsbasierte Informationen aus anderen Gehirnregionen, die eine angemessene Reaktion auf das visuelle Ereignis ermöglichen.

Fehlende Kontextinformationen

„Was wir an sich noch nicht richtig verstehen, ist die Art, wie im Gehirn bottom-up- und top-down-Informationen in einer funktionierenden Weise zusammengebracht werden. Denn wenn man die top down Informationen zufällig erhascht, dann halluziniert man, und man sieht, etwas das man sich vielleicht vorstellt, aber das nicht wirklich da ist. Die top-down Information muss also da sein, um die Information, die von unten kommt, zu unterstützen, ohne sie zu dominieren“, erklärt der Forscher.

Verständlich wird dies anhand eines Beispiels: Wenn vor einem autonom fahrenden Auto ein großer Plastikbeutel oder ein Karton vom Wind über die Straße geweht wird, dann steht das Auto vor der Entscheidung zu bremsen – oder nicht. Hier ist der Menschen der KI überlegen. Er hat Erfahrungswerte zum Gewicht von Kartons und was mit dem eigenen Auto oder anderen Verkehrsteilnehmern passiert, wenn man einfach drüberfährt.

Wie Hirnareale zusammenarbeiten

Maass: „Durch die Pixel der Kamera sieht man die Konsequenzen nicht so richtig. Will man die wenigen, aber oft verheerenden Unfälle mit autonom fahrenden Autos vermeiden, dann braucht es zusätzlich eine Art top-down Information. Schließlich muss man schnell reagieren und kann nicht erst sehen und dann nachdenken. Das ist ein Punkt, in dem sich die KI an der Sehfunktion im Gehirn orientiert und sich Hilfe erwartet.“

Das ist die nächste Frage, mit der sich der Grundlagenforscher Maass beschäftigen wird. Er will in einem Joint Forschungsprojekt mit dem Allen Institut untersuchen, wie verschiedene Hirnareale miteinander arbeiten und dies auch modellieren.

Die Ergebnisse wurden in der Zeitschrift Science Advances veröffentlicht.

Zur Originalpublikation: