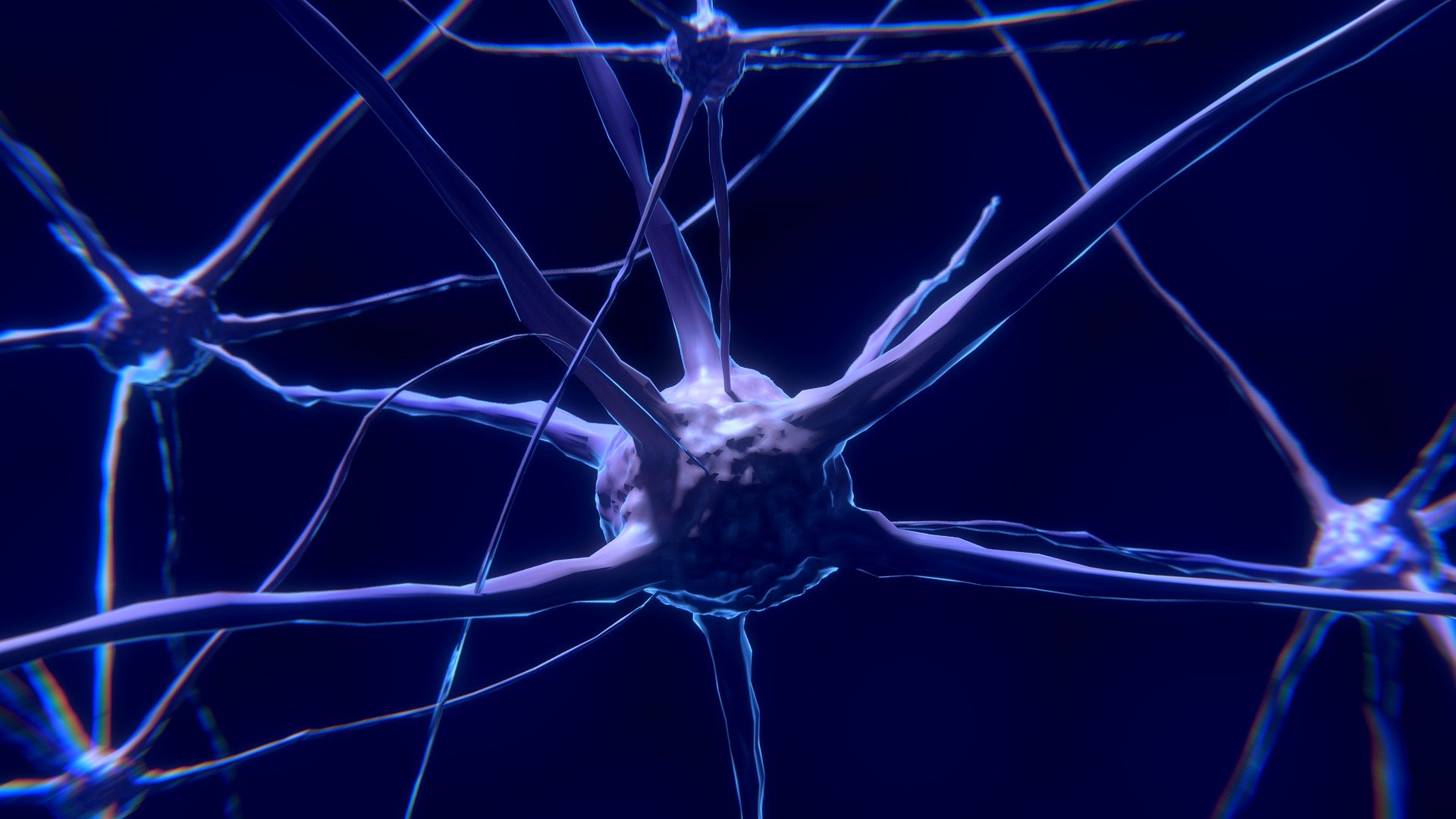

Neuro-informaticus Wolfgang Maass doet al twintig jaar onderzoek aan de Technische Universiteit Graz naar een hersenmodel van de muis. Hij is vooral geïnteresseerd in energie-efficiënte concepten zoals die in het biologische brein worden waargenomen. Nu is hij en zijn postdocs Chen Guozhang en Franz Scherr er voor het eerst in geslaagd een gedetailleerd model van het muizenbrein te trainen dat het vermogen heeft om te kunnen zien. Die kennis kan ertoe bijdragen dat AI-systemen beter leren ‘kijken’.

Kijken staat centraal

De visuele functie is van belang voor de informatica. Het is een van de centrale functies in de kunstmatige intelligentie. Dit blijkt uit voorbeelden zoals autonoom rijden en beeldverwerking. Dat de onderzoekers nu ook specifiek bepaalde visuele functies kunnen uitvoeren in hun op gegevens gebaseerde hersenmodel is te danken aan de prestaties van het gerenommeerde Allen Institute for Brain Science in Seattle. Dit instituut houdt zich onder meer bezig met het decoderen van de visuele cortex van muizen en heeft onlangs daarover gegevens openbaar gemaakt. “Dit was de eerste keer dat we de gegevens kregen waarmee we onze algemene knowhow met leven konden vullen,” zegt Maass.

Neuronen trainen

De gegevens van het Allen Instituut boden een waardevol kader voor het biologische visuele netwerk, maar het was een kader met enorm veel hiaten. De kennis van neurale netwerken zit namelijk in de gewichten van de synaptische verbindingen tussen neuronen, die moeilijk te meten zijn. De onderzoekers pasten machine learning toe om de ontbrekende biologische gegevens te vervangen door wiskundige optimalisatie. Neurologische netwerken, die dicht bij de biologie staan, zijn echter niet zo gemakkelijk te trainen.

“Biologische neuronen werken onregelmatig. In tegenstelling tot kunstmatige neuronen zenden ze actiepotentialen uit; geen langzaam veranderende waarde. Dit betekent dat de gradiëntmethode, die in de numerieke techniek wordt gebruikt om algemene optimalisatieproblemen op te lossen, niet kan worden toegepast,” legt professor Maass uit. Bij de gradiëntmethode gaat men vanaf een beginpunt langs een afdalingsrichting totdat geen numerieke verbetering meer wordt bereikt.

Hersenachtige visuele prestaties

Op basis van de gegevens van het Allen Instituut en hun eigen software ontwikkelden de onderzoekers een gedetailleerd grootschalig biologisch model van de primaire visuele cortex van de muis. De resultaten van de tests in het Jülich Supercomputing Center toonden aan dat het nieuwe hersenmodel verschillende visuele verwerkingstaken kan oplossen.

Het kan bijvoorbeeld beelden van handgeschreven nummers classificeren of visuele veranderingen in een lange reeks beelden herkennen. Het virtuele hersenmodel presteerde zeer nauwkeurig en haalde prestaties die vergelijkbaar waren met die van het muizenbrein. Zelfs wanneer het werd blootgesteld aan ruis in de beelden. Juist deze robuustheid tegen ruis in het beeld maakt het biologische model superieur aan de huidige modellen voor visuele verwerking in AI.

Een feit dat de onderzoekers verklaren door het feit dat hun model verschillende karakteristieke coderingseigenschappen van de hersenen repliceert. De onderzoekers gebruikten een standaardtest voor kunstmatige neurale netwerken. Vier van de tests waarvoor het model is getraind, kunnen echter ook door de muis worden geleerd. De muis kan bijvoorbeeld visuele veranderingen in een lange reeks beelden herkennen. Daarom kan het team de prestaties van de muis vergelijken met zijn model.

Neurale netwerken

Toch zou het zo kunnen zijn dat zicht bij muizen anders functioneert. Want in principe zijn biologie en kunstmatige intelligentie twee verschillende benaderingen om visuele functies in neuronale netwerken te bereiken. Bij de analyse van hun nieuwe hersenmodel vonden de onderzoekers beide. Kenmerken die overeenkomen met bevindingen uit biologische experimenten, maar ook kenmerken die daarvan afwijken.

“Daarom zijn op AI gebaseerde modellen zeer beperkt in het afleiden van visuele functies in de hersenen,” legt Maass uit, en vervolgt: “Wij waren de eerste die in dit onderzoek proberen die tweedeling in de biologie en AI duidelijk te illustreren.”

Minder energieverbruik

“Sommige van deze eigenschappen van het biologische brein zouden we graag kopiëren in AI,” zegt de onderzoeker. Bijvoorbeeld de energiezuinige activiteit van de neuronen, die meestal inactief zijn – en dus geen energie verbruiken. Dit wordt mogelijk gemaakt door zogeheten ‘specialisten’ in het brein. Dit zijn lokale netwerken in de hersenen die gespecialiseerd zijn in hun competentie.

Deze reageren alleen als ze echt iets hebben bij te dragen aan de oplossing van de taak. De neuronen in de kunstmatige neuronale netwerken bij machinaal leren zijn daarentegen bijna allemaal en voortdurend actief en verbruiken daarbij een enorme hoeveelheid stroom. In dit opzicht zijn veel sectoren van de industrie geïnteresseerd in het vinden van nieuwe benaderingen en het biologische prototype van de Graz-onderzoekers zou een inspiratiebron kunnen zijn voor nieuwe ontwerpen, aldus Maass.

Standaard

Het hersenmodel van de onderzoekers uit Graz biedt de mogelijkheid om een hypothese te implementeren en laat zien hoe de berekening in het model is georganiseerd, hoe deze verloopt en wat het model onder bepaalde omstandigheden kan doen. Als zodanig vormt zij een standaardwaarde waarmee ook vele andere modellen uit de biologie kunnen worden getoetst en vergeleken. Om het energieverbruik van neuronen van kunstmatige en biologische neuronale netwerken te vergelijken, implementeren de onderzoekers momenteel het hersenmodel op een Intel-chip, die beschikbaar zal worden gesteld voor onderzoek.

Zichtfunctie

Wanneer technologiebedrijven zoals Intel en IBM werken aan alternatieve methoden voor vision op chips, ligt de nadruk op energie-efficiëntie en intelligentie die in-vision moet worden geïntegreerd, weet Maass. De visiefunctie in AI-systemen is gebaseerd op bottom-up informatie. Dit betekent dat de camera informatie levert die tijdens de verwerking steeds abstracter wordt. De hersenen handelen anders. Het combineert heel snel de informatie van het oog met top-down informatie. Dit is op ervaring gebaseerde informatie uit andere hersengebieden die een passende reactie op de visuele gebeurtenis mogelijk maakt.

Context

“Wat we nog niet echt begrijpen, is hoe bottom-up en top-down informatie op een functionerende manier in de hersenen wordt samengebracht. Want als je de top-down informatie toevallig opvangt, dan hallucineer je, en zie je iets dat je je misschien voorstelt, maar dat er niet echt is. De top-down informatie moet er dus zijn om de informatie die van beneden komt te ondersteunen zonder deze te domineren,” legt de onderzoeker uit.

Neem bijvoorbeeld een situatie waarbij een grote plastic zak of een kartonnen doos door de wind over de weg wordt geblazen. Bij een autonoom rijdende auto, staat de auto voor de beslissing om te remmen of door te rijden. Dat is voor het systeem een heel moeilijk besluit. Hier zijn mensen superieur aan AI. Zij hebben ervaring met het gewicht van kartonnen dozen en wat er met hun eigen auto of andere weggebruikers gebeurt als je er gewoon overheen rijdt.

Maass: “Als je de weinige maar vaak fatale ongelukken met autonoom rijdende auto’s wilt vermijden, heb je ook een soort top-down informatie nodig. Je moet immers snel reageren. Je kunt niet eerst waarnemen en dan denken. Dat is een punt waarop de AI zijn aanwijzing haalt uit de visuele functie in de hersenen en hulp verwacht.”

Dat is de volgende vraag die Maass wil oppakken. In een gezamenlijk onderzoeksproject met het Allen Instituut wil hij onderzoeken hoe verschillende hersengebieden met elkaar samenwerken en dit ook modelleren.

Het onderzoek is gepubliceerd in Science Advances.