Das Locked-in Syndrom ist eine seltene neurologische Erkrankung. Oft wird es von Amyotrophischer Lateralsclerose (ALS) ausgelöst, eine unheilbare degenerative Erkrankung des motorischen Nervensystems. Betroffene laufen Gefahr, die vollständige Muskelkontrolle zu verlieren. Bewusstsein und geistige Funktionen bleiben jedoch intakt. Das heißt, Betroffene können sehen und hören, aber als Verständigungsmöglichkeit bleiben meist nur die Augenlider. Eine entscheidende Erleichterung der Verständigung mit Locked-in-Patienten erwartet man sich von Gehirn-Computer-Schnittstellen – sogenannten Brain Computer Interface (BCI)-Technologien. Diese basieren auf dem Befund, dass schon die Vorstellung eines Verhaltens messbare Veränderungen der elektrischen Hirnaktivität auslöst. Zum Beispiel führt die Vorstellung, eine Hand oder einen Fuß zu bewegen, zur Aktivierung des motorischen Kortex.

Bei Brain-Computer Interface Technologien unterscheidet man in invasive und nicht invasive Methoden. Bei nicht invasiven Methoden misst man die Gehirnaktivität mittels Elektroden, die händisch auf der Kopfhaut befestigt werden. Die Messungen basieren auf Elektroenzephalographie (EEG), die den Nachteil einer geringen Signalauflösung und einer eingeschränkten Genauigkeit haben.

Invasive Brain Computer Interface Technologien

Mit invasiven Methoden können diese Schwächen kompensiert werden, da Elektroden für Elektrokortikogramm-Messungen eingesetzt und über dem motorischen Kortex implantiert werden. Bis dato hakt die Anwendbarkeit invasiver Brain- Computer Interface Technologien noch an einer angestrebten Miniaturisierung und der hohen räumlichen Auflösung, da dies eine große Zahl an Messpunkten auf kleinem Raum erfordert. Außerdem kann die Software noch nicht von den Betroffenen allein angewendet werden. Sowohl bei den EEG-basierenden als auch bei den intrakortikalen Systemen muss immer wieder kalibriert werden, um die Algorithmen wieder auf den aktuellen Tageszustand zu bringen, erklärt Professor Gernot Müller-Putz vom Institut für Neurotechnologie an der TU Graz.

Er forscht aktuell im europäischen Forschungskonsortium INTRECOM, das diese Probleme lösen will. Die implantierbare Technologie soll Sprache in Echtzeit aus Gehirnsignalen entschlüsseln können. Locked-in Patienten soll damit erstmals ein vollständiges und einfach zu bedienendes Kommunikationssystem zur Verfügung stehen, mit dem sie sprechen und einen Computercursor steuern können.

Vorstellung eines Verhaltens

Das Konsortium von Forschungs- und Industriepartnern wird von Professor Nick Ramsey vom niederländischen Universitätsklinikum UMC Utrecht geleitet. Er hat schon in einer Vorarbeit gezeigt, dass man eine versuchte Handbewegung detektieren und als Mausklick verwenden kann. Das funktioniert wie in einer assistive technology, in der einzelne Buchstaben abgescannt werden und der Patient Buchstaben auswählen und anklicken kann, erklärt Professor Müller-Putz.

Er selbst schloss eben das EU-Projekt Feel Your Reach ab, in dem er die Trajektorien von vorgestellten Armbewegungen mit einer bestimmten Wahrscheinlichkeit aus EEG-Signalen errechnen konnte. Diese Technologie soll im aktuellen Projekt noch verfeinert werden. An der TU Graz lag der Schwerpunkt bisher auf nicht-invasiven Brain-Computer Interface Technologien. Gemeinsam mit Professor Ramsey arbeitet Müller-Putz jetzt erstmals mit Elektrokortikogramm (ECoG) Messungen, bei denen das Material, auf dem die Elektroden fixiert sind – das sogenannte Array – direkt auf dem motorischen Kortex aufliegt.

Zwei Forschungsansätze

Um sicher einen Forschungsfortschritt zu erzielen, verfolgen die Forschungspartner zwei Ansätze: Das Team Ramsey will Sprache aus versuchter Sprache erzeugen. Das heißt, die Forscher bewerten den Versuch der Person, die einzelne Laute eines gesprochen Wortes zu produzieren. Auf diese Weise können sie aus den Gehirnsignalen in Echtzeit ablesen, was die Person sagen will.

Das Team Müller-Putz konzentriert sich auf jegliche zusätzliche Form der Kommunikation, die man über Cursor-Bewegungen beschreiben kann: Angefangen von der einfachen Auswahl von Icons am Bildschirm bis hin zu Bewegungen des Cursors und zur Auswahl, die der Patient steuern kann.

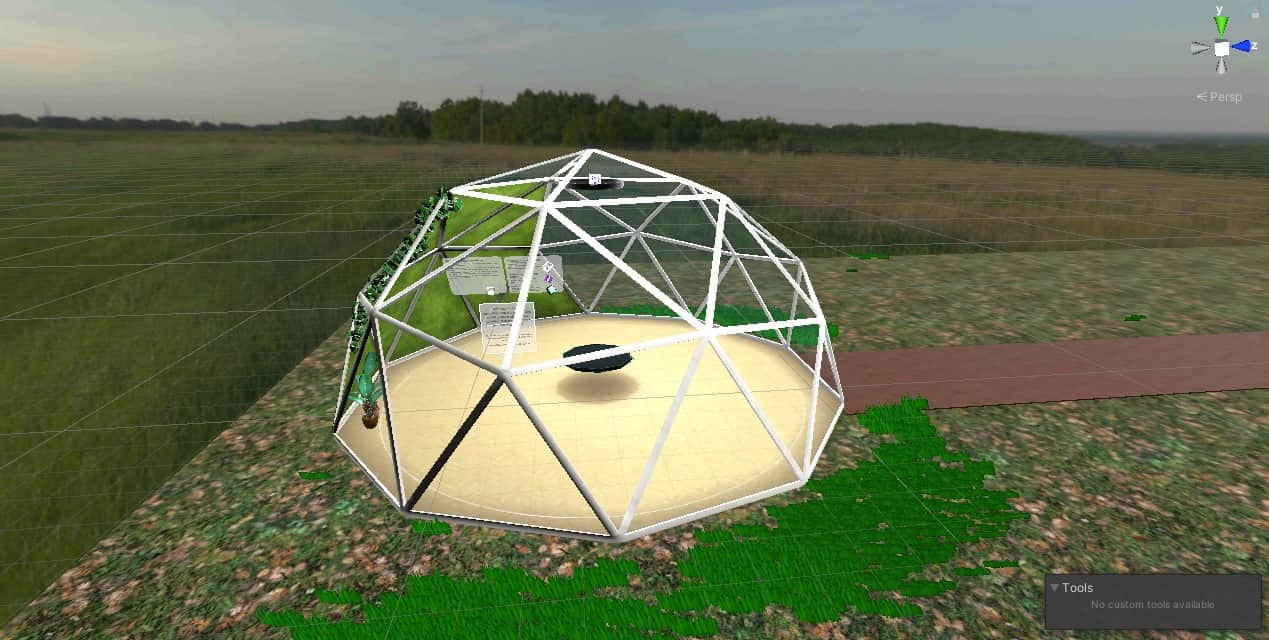

Die Hardware des Brain Computer Interface besteht aus einem Elektrodenarray – einem sogenannten Array – und einem Biosignalverstärker. Während das Array von Elektroden über den motorischen Arealen platziert wird, implantiert man den Biosignalverstärker in den Schädelknochen. Letzterer hat die Aufgabe, die Daten zu verarbeiten und diese drahtlos an externe Computer zur Analyse und Dekodierung zu übertragen.

Miniaturisierung vs. Hochauflösung

Zu den technischen Herausforderungen zählt die erwähnte Miniaturisierung, die Voraussetzung für die Implantierung ist. Bei der Aufzeichnung der Hirnsignale ist eine hohe örtliche Auflösung erforderlich. Das bedeutet, sehr viele Messpunkte in Relation zur Größe des Arrays. Je kleiner das Array, umso dichter müssen die Elektroden angeordnet werden. Die zeitliche Auflösung wird im Millisekundenbereich gemessen. Beides, sowohl die hohe räumliche als auch die hohe zeitliche Auflösung, sind grundlegend für die Entschlüsselung von Sprache in Echtzeit.

Um die Hirnsignale in gesprochene Worte umzusetzen, werden über Algorithmen Parameter aus den Messdaten extrahiert. Diese beschreiben, ob der Mund Laute generieren oder die Hand den Cursor bewegen will. Letztendlich muss das System noch in eine Software eingebettet werden, die ohne technischen Experten in der Heimanwendung funktioniert. Dazu muss das System einfach zu bedienen und robust sein und gleichzeitig die neuesten AI-basierten und selbstlernenden Technologien nutzen.

Die Industriepartner

Für die Konstruktion der Hardware sind die zwei Industriepartner im Konsortium zuständig: das Schweizer Wyss Center für Bio- and Neuroengineering konstruiert den Biosignalverstärker und der deutsche Medizintechnikhersteller CorTec wird Teile der implantierbaren Elektronik entwickeln, die die Gehirnsignale aufzeichnen: maßgefertigte hochauflösende ECoG-Elektroden mit hochkanaliger Verkabelung.

„Die Einzelbauteile gibt es schon in verschiedenen Ausführungen, und wir werden diese jetzt verfeinern und erstmals in der Art und Weise verschiedene Dinge zusammenführen, damit wir das entsprechend umsetzen können. Das ist das Spannende dabei“, sagt Müller-Putz. Erprobt werden soll das Brain-Computer Interface an zwei Personen mit Locked-in Syndrom in Utrecht und in Graz.

Zum Projekt Intrecom

Das Projekt soll im Herbst starten. Professor Müller-Putz arbeitet gerade an den Vorbereitungen und sucht noch nach interessierten Postdoktoranden und Dissertanten für das Team am Institut für Neurotechnologie an der TU Graz.

Intracranial Neuro Telemetry to REstore COMmunication (INTRECOM) wurde vom European Innovation Council (Pathfinder Programme) ausgewählt und wird mit knapp vier Millionen Euro von der EU gefördert. Das Projekt läuft von Herbst 2022 bis Herbst 2026.