Gene Roddenberry hat bereits 1966 den Universalübersetzer mit automatischer Spracherkennung erfunden, wenn auch nur für Captain Kirk, Spock und ihre Kollegen auf dem Raumschiff Enterprise. Rund 50 Jahre später ist ein Startup aus Gilching-Oberpfaffenhofen bei München durch intelligente Audioanalyse auf dem Weg, einem Universalübersetzer in der wahren Welt einen kleinen Schritt näherzukommen.

Von einem echten Universalübersetzer ist man zwar noch weit entfernt, aber die Grundlagen werden bereits gelegt. „Die Technologie ist heutzutage so weit, dass unabhängig von der Landessprache die Merkmale einer Person und ihre Emotionen erkannt und verstanden werden können”, erklärt Dagmar Schuller, Geschäftsführerin von audEERING. Gemeinsam mit ihren Kollegen Florian Eyben, Björn Schuller und Martin Wöllmer hat sie audEERING, das aus der gemeinsamen Forschungsarbeit an der TU München entstanden ist, 2012 gegründet.

Mittlerweile ist das Münchner Startup führend auf dem Gebiet der intelligenten Sprachanalyse und stellt Software her, die „auf Standardgeräten wie Smartphones, Tablets aber auch unabhängig davon benutzt werden kann” und nicht nur für die Automobilbranche, sondern insbesondere in Medizin und Pflege immer wichtiger wird. „Ein Arzt, der die Software auf seinem PC installiert hat, kann durch die intelligente Sprachanalyse, während der Patient erzählt, erkennen, wie sich der emotionale Zustand und andere Stimmmerkmale verändern und sich über die Zeit entwickeln”, sagt Schuller. „Das ist insbesondere wichtig, wenn es beispielsweise in der Demenzforschung darum geht, Anomalien oder Abweichungen frühzeitig zu erkennen. In der Biografiearbeit ist es für viele Patienten leichter, ihre Gedanken per Spracheingabe festzuhalten, als ein schriftliches Tagebuch zu führen. Das ermöglicht zusätzlich, die Daten automatisiert auszuwerten und die unterbewusste emotionale Situation des Menschen zu erkennen.”

Dank der einzigartigen VocEmoApI-Technologie ist es möglich, mehr als 50 Emotionen und -zustände wie Zufriedenheit, Ärger oder Traurigkeit zu erkennen und Entwicklungen schon früh zu erkennen. So könne auch schon sehr viel früher vorhergesagt werden, ob Indikatoren für Demenz vorhanden seien oder nicht. Auch bei der Prävention von Parkinson erkenne die künstliche Intelligenz Veränderungen in der Stimme, die durch die Lähmung der feinen Kehlkopfmuskeln ausgelöst werden. Diese Merkmale können bereits wesentlich vor anderer allgemeinen Symptomatik erkannt werden, im besten Fall sogar viele Monate vorher. Alles kann künstliche Intelligenz aber trotzdem noch nicht und der Mensch steht auch weiter im Zentrum. „Technologie erkennt die Merkmale der Stimme und der Akustik, aber wichtig ist trotzdem immer noch der Mensch, der dann in der Lage ist, diese Daten zu interpretieren und auszuwerten.”

Ein aktuelles Projekt von audEERING wird sogar von der EU gefördert. Im Rahmen des Forschungsprojekts ECoWeB entwickelt audEERING im Konsortium eine App, bei der Jugendliche ganz neutral erkennen können, ob sie depressive Verstimmungen haben. „Das ist gerade bei Jugendlichen, die sich weniger dem Menschen anvertrauen und einen leichten Zugang zu Technik haben, sehr hilfreich. ”

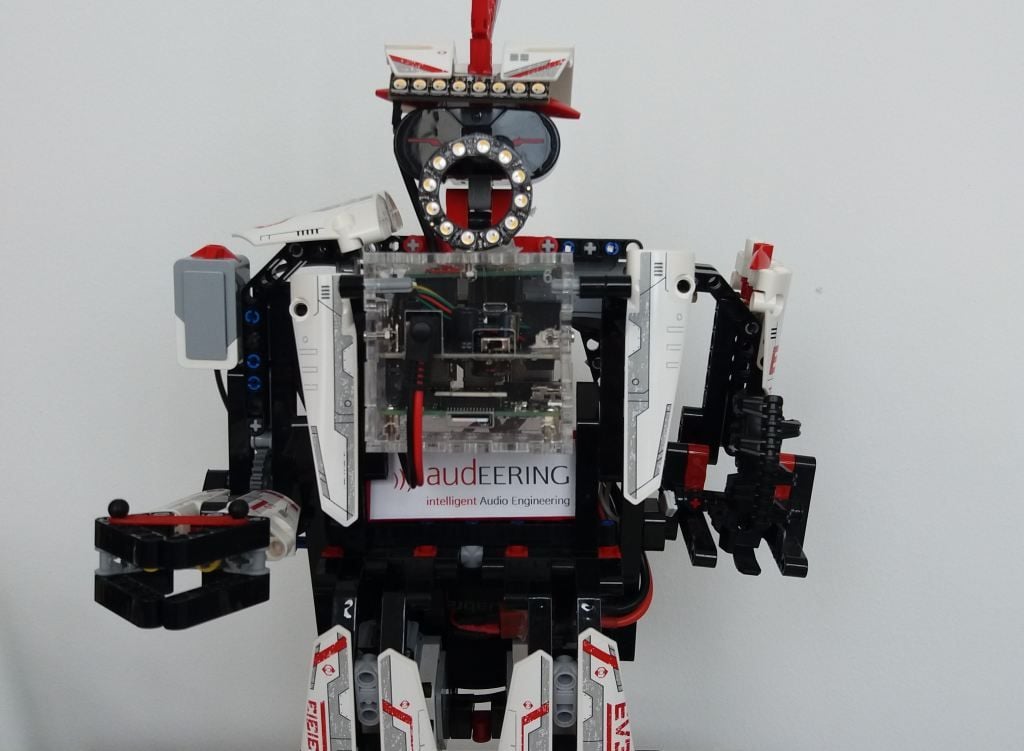

Und auch in Amerika spielt die Software aus München eine Rolle. Das US-amerikanische Unternehmen Jibo nutzt für den ersten gleichnamigen sozialen Roboter die intelligente Audioanalyse-Technologie von audEERING. Dadurch erkennt der 30 Zentimeter große Jibo menschliche Sprache in Kombination mit Video und setzt so auf multimodale Eingabeerkennung als Grundlage für soziale Kompetenz.

Foto: audEERING