Dinge wie Suchmaschinen und selbstfahrende Autos basieren auf künstlicher Intelligenz. Dahinter stecken komplexe neuronale Netze. Bisher konnten die zugrundeliegenden mathematischen Modelle nur mit enormen Rechenleistungen umgesetzt werden und sind für Menschen schwer nachvollziehbar. Professor Radu Grosu, Leiter der Forschungsgruppe Cyber Physical Systems an der TU Wien, denkt schon seit Jahren darüber nach, wie Vorbilder aus biologischen Nervensystemen künstliche Netzwerke besser und verständlicher machen könnten.

Überprüfbarkeit

Neuronale Netzwerke bestehen – wie die Gehirne lebendiger Wesen – aus vielen einzelnen Zellen. Wenn eine bestimmte Aufgabe zu lösen ist, dann sendet eine aktive Zelle ein Signal an andere Zellen. Die Summe der Signale, welche eine Zelle erhält, entscheidet darüber, ob diese ebenfalls aktiv wird. Wie Zellen die Aktivität anderer Zellen auf diese Weise beeinflussen, bleibt zunächst unklar. Die Parameter werden in einem automatischen Lernprozess so lange angepasst, bis das neuronale Netzwerk die Aufgabe lösen kann.

Auch interessant: Auch Roboter werden kreativer, wenn man sie ihre eignen Erfahrungen machen lässt

Für Menschen ist der Lernprozess von außen kaum einsehbar und oft nicht verständlich. Weshalb man von einer Black Box spricht. Um das Vertrauen in die Künstliche Intelligenz zu stärken, sind vom Menschen überprüfbare Systeme gefordert.

Zuletzt versuchte Professor Grosu das Problem in einem internationalen Forschungsprojekt zu lösen – gemeinsam mit Forschern von Massachusetts Institute of Technology MIT USA, TU Wien und Institute of Science and Technology IST Austria. Das biologische Vorbild lieferte der Caenorhabditis elegans, der Fadenwurm, einer der wichtigsten Modellorganismen der Biologie. Er ist klein, durchsichtig, genügsam und braucht für seine Entwicklung nur drei Tage. Obwohl er nur über wenige Nervenzellen verfügt, zeigt er doch verblüffend interessante Verhaltensmuster. Das liegt an der effizienten und harmonischen Art, in der sein Nervensystem Informationen verarbeitet, weiß Professor Grosu.

Grundlage für neuronale Netze

Trotzdem, „verglichen mit der Struktur von Deep Neural Networks (DNNs) wirkt das Nervensystem des C. Elegans auf den ersten Blick chaotisch“, sagt Mathias Lechner, PhD-Student in der Henzinger Group am IST Austria. Die Grundlage für das neuartige neuronale Netz lieferten die Funktionen der Neuronen. Lechner: „Neurowissenschafter unterteilen die Neuronen des Systems in die Gruppen Sensory, Inter und Motor. Bei den Inter-Neuronen gibt es zusätzlich die Untergruppe der Command-Neuronen, in welchen wichtige Signalwege konzentriert sind. „Im C. elegans Nervensystem gibt es zum Beispiel Command-Neuronen für Vorwärts- und Rückwärts-kriechen in denen sich die Signalwege der Bewegungssteuerung konzentrieren. Die Vorwärts- und Rückwärtsbewegungen sind jedoch selbst wesentlich komplexer und erfordern die Zusammenarbeit von mehreren Neuronen und Muskeln.“

Um an die Effizienz und Harmonie des Nervensystems von C. Elegans heranzukommen, entwickelte die Forschergruppe neue mathematische Modelle für Neuronen und Synapsen. Auch für die die Verarbeitung der Signale innerhalb der einzelnen Zellen entwickelten sie neue mathematische Regeln, die von jenen bei bestehenden Deep Learning Modellen abweichen. Weiters vereinfachend wirkte, dass nicht jede Zelle mit jeder Zelle verbunden wurde.

Testszenario

Testszenario war das Spurhalten beim autonomen Fahren. Dabei arbeitet das neuronale Netzwerk aufgrund eines Kamerabilds von der Straße und entscheidet automatisch, ob nach rechts oder nach links gelenkt werden muss. Bei bestehenden Deep Learning Modellen erfordert diese Aufgabe Millionen an Parametern. Das neue Modell der Forschergruppe kommt indessen mit nur 75.000 trainierbaren Parametern aus.

In Vorbereitung des Tests wurden große Mengen an Videos von menschgesteuertem Autofahren im Raum Boston gesammelt. Diese wurden in das Netzwerk eingegeben, gemeinsam mit der Information, wie das Auto in den jeweiligen Situationen gesteuert werden soll. Dieser Trainingsprozess währt so lange, bis das System die richtige Verknüpfung von Bild und Lenkrichtung gelernt hat und auch mit neuen Situationen selbstständig umgehen kann.

Das Künstliche Intelligenz Modell besteht aus zwei Teilen, einem konvolutionalen Netzwerk und einem Kontrollsystem. Beide Teilsysteme werden zunächst gemeinsam trainiert. Das konvolutionale Netzwerk hat die Aufgabe, in den visuellen Daten aus der Kamera strukturelle Bildeigenschaften zu erkennen. Die relevanten Teile des Kamerabildes gibt dieses in Form von Signalen an das Kontrollsystem weiter, welches das Fahrzeug lenkt.

Das Kontrollsystem des neuronalen Netzwerks (genannt „neural circuit policy“, oder NCP), das die Daten aus dem visuellen Netz in einen Steuerungsbefehl übersetzt, besteht aus nur 19 Zellen. Damit ist es um drei Größenordnungen kleiner als bestehende State-of-the-art-Modelle.

Interpretierbare neuronale Netze

Das Modell ermöglicht es, genau zu untersuchen, worauf das neuronale Netzwerk seine Aufmerksamkeit beim Fahren richtet. Es konzentriert sich auf ganz bestimmte Bereiche des Kamerabildes: Auf den Straßenrand und den Horizont. Dieses Verhalten ist höchst erwünscht, und es sei einzigartig bei Systemen, die auf künstlicher Intelligenz beruhen.

„Klassische Deep Neural Networks (DNNs) können ebenfalls korrekte Fokussierungen erlernen, allerdings lässt sich die Fokussierung erst nach dem Trainingsprozess bestimmen und man kann vor dem Training nicht bestimmen, welche Elemente gelernt werden. Unser von C. elegans inspiriertes Modell hat den Trainingsprozess implizit so beeinflusst, dass die Fokussierung auf dem Horizont liegt. Warum und wie das Modell den Trainingsprozess beeinflusst hat, um dieses Ergebnis zu liefern, ist in der Forschungsarbeit nicht beantwortet, also noch offenes Forschungsgebiet.“ Mathias Lechner, PhD Student IST Austria

Außerdem lasse sich die Rolle jeder einzelnen Zelle bei jeder einzelnen Entscheidung identifizieren. Die Funktion der Zellen sei verständlich und ihr Verhalten erklärbar. Dieses Maß an Interpretierbarkeit sei in größeren Deep Learning-Modellen bisher unmöglich, so die Forscher.

Robustheit

Ein Mangel von bestehenden Deep Learning Modellen ist auch dass sie unfähig sind, mit schlechter Bildqualität umzugehen. Experten sprechen vom sogenannten Bildrauschen. Auch diese Eigenschaft konnte in dem neuartigen System verbessert werden. Das zeigte eine Analyse, in der das neuronale Netz mit künstlich beschädigten Bildern konfrontiert wurde. Diese Robustheit sei eine direkte Folge von Konzept und Architektur der Innovation, so die Forscher.

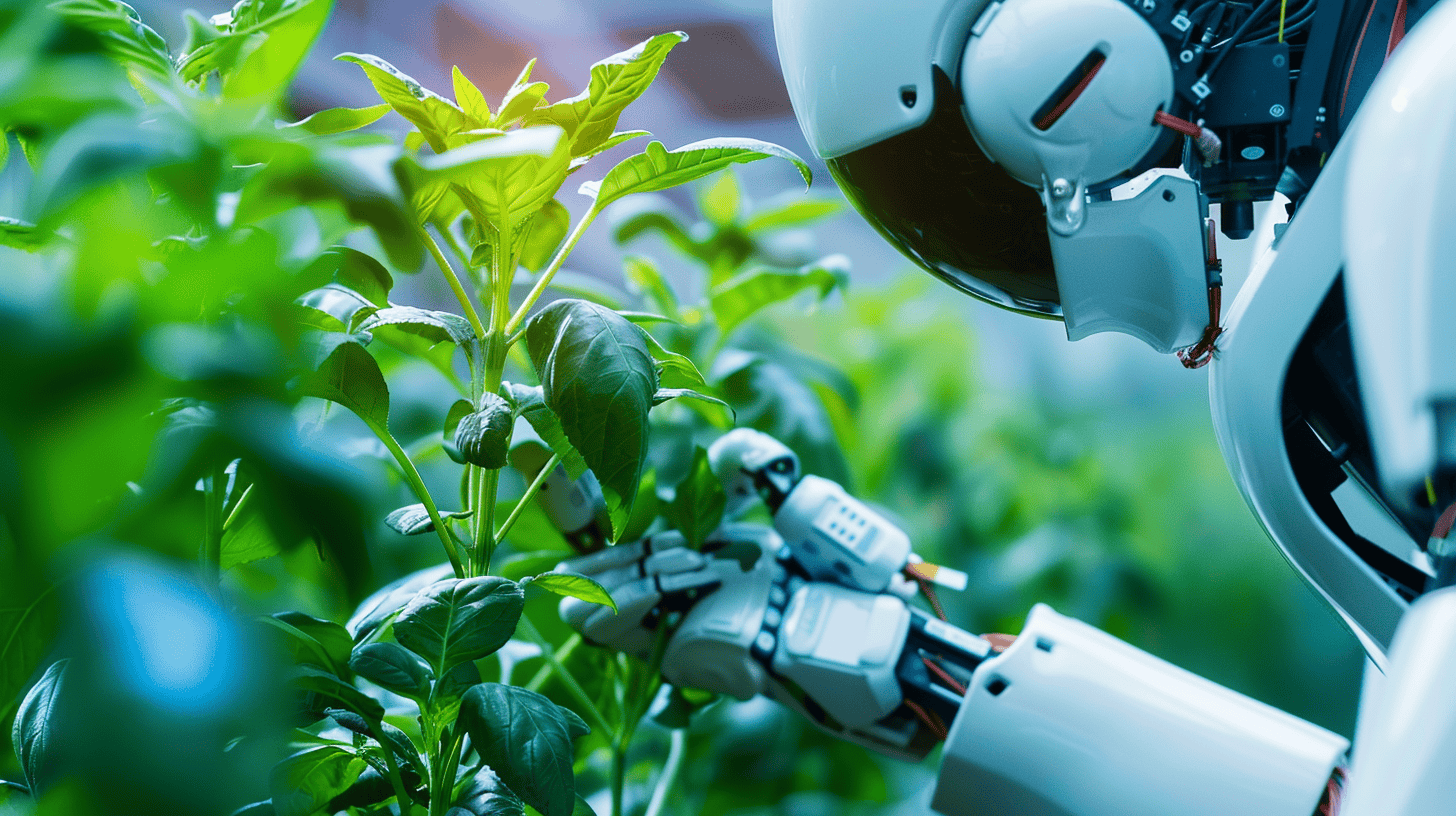

Darüberhinaus bedürfen die angewendeten Methoden einer kürzeren Trainingszeit und können folglich selbst in relativ einfache Systeme implementiert werden. Das Deep Learning-Modell, welches das internationale Forscherteam entwickelte, macht imitierendes Lernen in einem weiten Anwendungsbereich möglich, von automatisierter Arbeit in Lagerhallen bis hin zur Bewegungssteuerung von Robotern.

Die Forschungsergebnisse wurden in nature.com veröffentlicht:

M. Lechner, R. Hasani, A. Amini, T. Henzinger, D. Rus, R. Grosu. 2020. Neural Circuit Policies Enabling Auditable Autonomy. Nature Machine Intelligence. https://www.nature.com/articles/s42256-020-00237-3

Auch interessant: „Es ist utopisch zu glauben, dass Menschen eine unfehlbare künstliche Intelligenz schaffen können”