De schrijfrobot ChatGPT is momenteel een rage. Sommigen verwachten inmiddels de wereld ervan. Zozeer zelfs dat we lijken te vergeten wat het eigenlijk is: een taalmodel. En dat betekent dat het niet geschikt is voor allerlei taken die andere intelligente machines wel kunnen. Zoals schaken.

De prestaties van ChatGPT op het gebied van taal zijn zonder twijfel indrukwekkend. Maar dat betekent niet dat het systeem alles kan. Schaken tegen ChatGPT is ronduit hilarisch.

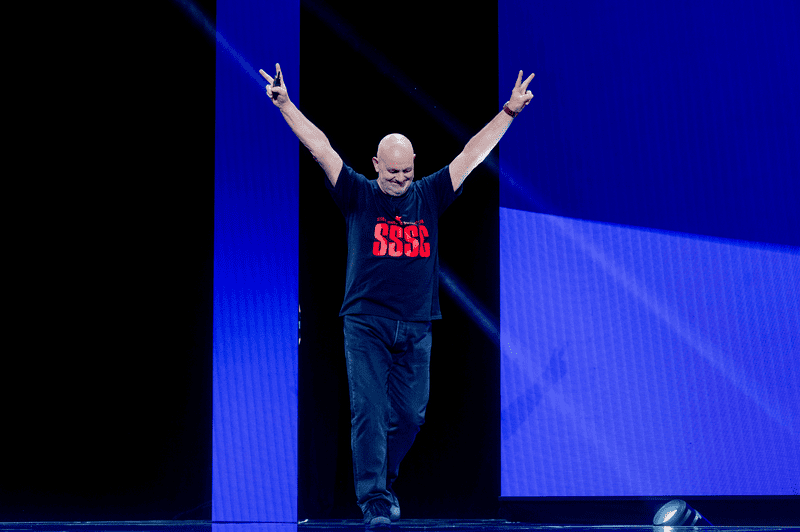

Open AI’s Large Language Model (LLM) kan gewoon niet coherent spelen of zich zelfs maar aan de regels houden. Laat staan winnen. Een vermakelijk voorbeeld is de partij van Youtuber en internationaal meester Levy Rozman (GothamChess op YouTube) tegen de AI, waarin ChatGPT onder meer een reeks absurde, niet toegestane zetten speelde. Het sloeg zijn eigen loper na drie zetten, genereerde stukken uit het niets en nam zelfs zijn toevlucht tot het verplaatsen van stukken van de tegenstander in het eindspel.

In sommige gevallen speelde ChatGPT na een onrechtmatige zet, wanneer Rozman hem daartoe aanzette, een andere zet die meestal net zo vreemd en niettoegestaan was als de vorige. In een online artikel vertelde oprichter Marc Cressac van Chessily.com Stockfish 15.1 – de meest geavanceerde schaak-AI die tot nu toe is ontwikkeld – over een partij die hij tegen ChatGPT speelde.

Waarschijnlijk vindt ChatGPT niet veel plezier in het volgen van strikte regels. Misschien heeft het schaakspel na 1500 jaar een opfrisbeurt nodig en is ChatGPT er om die te geven. Een staatsgreep op een van de meest populaire spellen in de menselijke geschiedenis, het onttronen van de autoriteit van spelregels en het ontregelen van de status quo.

Hoe ChatGPT schaakt

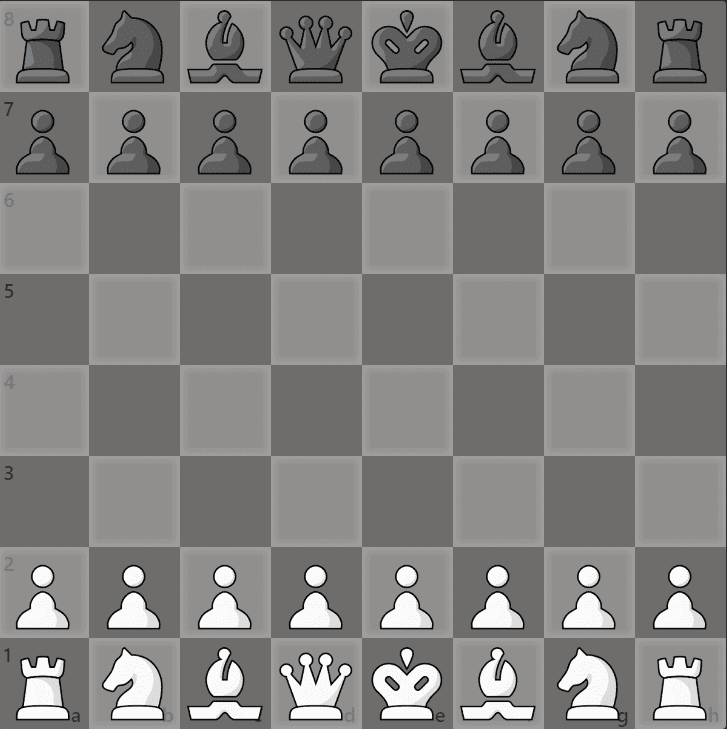

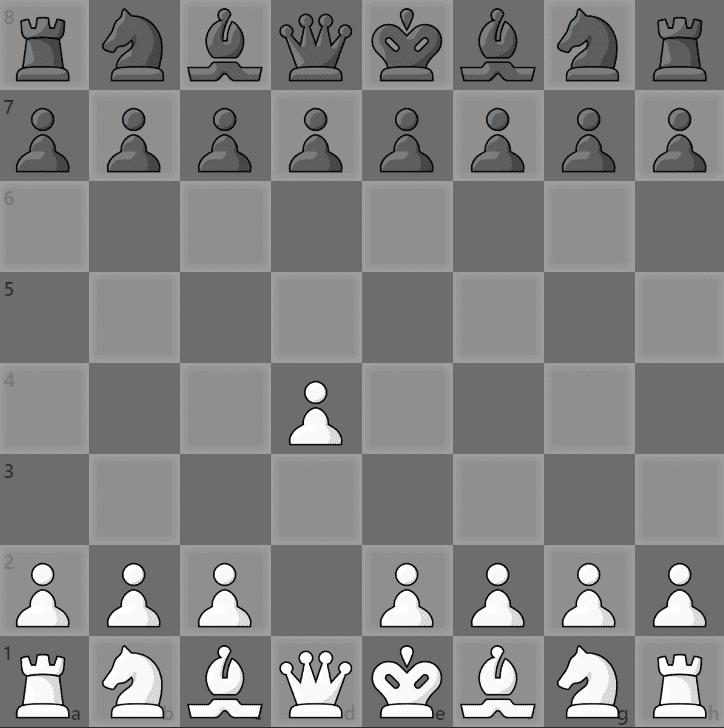

Alle gekheid op een stokje, laten we een stap terug doen en bekijken hoe ChatGPT eigenlijk schaakt. Het programma is een Groot Taalmodel, hetgeen wil zeggen: een kunstmatige intelligentie die alleen informatie kan produceren via geschreven taal in antwoord op een prompt en alleen kan spelen via het algebraïsche notatiesysteem. Wat is dat? Dat is een systeem dat identificeert hoe een van de 32 stukken op het bord van 8 bij 8 kan bewegen. Waarbij een hoofdletter wordt toegekend aan een stuk (met uitzondering van pionnen, die alleen worden geïdentificeerd door het veld waarheen ze bewegen), gevolgd door een kleine letter en een cijfer die een van de 64 velden op het bord aanduiden. Hier een voorbeeld:

Wit’s paard op het g1 veld is verhuisd naar f3. In algebraïsche notatie kan dit worden uitgedrukt als “Ng1 -> f3” of gewoon “Nf3”, omdat in deze specifieke positie het veld f3 slechts geoorloofd kan worden bereikt door één van de twee paarden. Dit is waar ChatGPT gebruik van kan maken bij het schaken, aangezien het geen toegang heeft tot een ingebouwd bord.

Omdat het taalmodel zo geavanceerd is, denken mensen dat het derhalve ook in staat moet zijn succesvol te kunnen schaken. Temeer daar zelfs grootmeesters zich erbij hebben neergelegd dat ze categorisch verslagen worden door schakende systemen als de almachtige Stockfish, zonder kans op zelfs maar remise.

Dus de schaakprestaties van ChatGPT zouden technisch gezien geweldig moeten zijn, toch? Nou, niet per se. Het systeem is simpelweg niet specifiek getraind om te schaken. Dat komt vanwege de manier waarop een groot taalmodel werkt.

Taalmodellen

“In wezen kan een LLM je vertellen wat de kans is dat een stel woorden in een gegeven reeks voorkomt,” legt dr. Evangelos Kanoulas, hoogleraar aan het Informatica Instituut van de Universiteit van Amsterdam, uit. “Het kan je dus vertellen hoe waarschijnlijk een stuk tekst is”.

Bovendien worden woorden uit de natuurlijke taal omgezet in tokens, waarbij elk woord overeenkomt met 1 tot 3 tokens. Ook, zegt Kanoulas, kan een LLM voorwaardelijke waarschijnlijkheid gebruiken om woorden te koppelen. Wat betekent dat het op basis van een bepaald woord kan ‘raden’ wat het volgende woord (of token) zal zijn. Dus, hoe groter het taalmodel is, hoe meer het een goede schatting kan geven van wat het volgende woord zal zijn.

“Laten we aannemen dat deze machine is getraind door te kijken hoe mensen woorden gebruiken”, vervolgt Prof. Kanoulas. “Waarschijnlijk heeft hij ook schaakpartijen gezien. Dus, iemand schrijft ‘Chess game, player one’ en dan de eerste zet, bijvoorbeeld d4. Dus nu leert de AI dat wanneer een partij begint, de kans groot is dat de eerste zet d4 is, omdat hij dat ergens gelezen heeft. ChatGPT heeft geen idee wat dit is. Het weet niet wat schaken is en kent de regels niet.”

In principe analyseert de AI de taal, herkent de woorden die het begin van een schaakpartij aangeven en antwoordt met een gok gebaseerd op wat waarschijnlijk een passend antwoord is op een specifieke vraag.

Ook kan de machine generaliseren. Dat wil zeggen dat hij een reeks woorden kan produceren, ook al heeft hij nog nooit een specifieke prompt gezien. Misschien heeft hij soortgelijke of correlerende woorden gezien en haalt hij daar informatie uit. Dus, zonder begrip van de schaakregels, en na wellicht een groot aantal artikelen over schaakpartijen met verschillende eerste zetten te hebben gezien, produceert het een gegeneraliseerd antwoord.

Dat kan resulteren in ons voorbeeld “d4”. Dat is echter geen computeranalyse van alle partijen die de AI ooit heeft gezien, maar slechts een linguïstische voorspelling. Met andere woorden, ChatGPT speelt “d4” niet omdat het weet dat het een verstandige zet is. Dat doet het alleen omdat de populariteit van de zet in echte schaakwedstrijden ervoor heeft gezorgd dat de tekst “d4” vele malen is verschenen als het begin van een partij.

“Eén ding dat het weet,” zegt prof. Kanoulas, “is dat in dit geval een letter waarschijnlijk niet gevolgd wordt door een andere letter, dus het mag niet “dd” doen. Maar het zou kunnen. Misschien gebeurt er iets vreemds, zoals een mens die een ongeorloofde zet doet die de waarschijnlijkheid van wat de AI vervolgens gaat doen verbreekt. Er zal iets vreemds uitkomen.”

Wat weet de kunstmatige intelligentie?

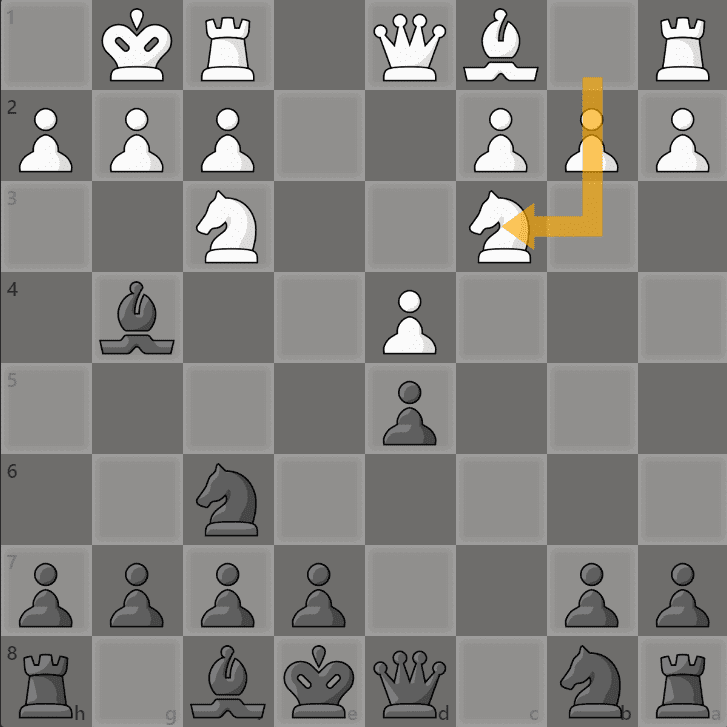

Ten onrechte denken sommigen misschien dat ChatGPT weet dat het speelveld een 8 bij 8, geruit bord is. Zelfs dat niet. Nogmaals, de reden waarom ChatGPT tijdens het spelen waarschijnlijk niet voorbij de letter “h” en het getal 8 zal gaan is niet omdat het weet dat het dat niet kan doen. Integendeel, het heeft eenvoudigweg nog nooit, of toch hoogst zelden, gezien dat iemand een tekst met betrekking tot een schaakzet voorbij “h” of 8 typte. Toch kan het nog heel veel fouten genereren. In de eerder genoemde YouTube-video van Rozman bijvoorbeeld, bewoog ChatGPT, nadat het zijn eigen loper had geslagen door illegaal te rokeren, zijn paard van het b1-veld naar het c3-veld, waardoor het zich in de positie bevond die op het volgende bord wordt getoond.

Voor deze zet gaf de AI het volgende commentaar: “Ik speel Nc3 [Paard naar c3], val uw loper aan en ontwikkel een stuk”. Hoewel de zet het paard zeker ontwikkelt (in schaaktaal: “vooruitbrengt” of “een bepaald stuk verder laat komen”), valt hij op geen enkele manier een loper van Rozman aan. ChatGPT kan dit commentaar hebben gegeven omdat het vaak voorkomt dat paarden de lopers aanvallen, alleen niet in deze positie en normaal gesproken alleen als dat binnen de regels eerlijk en legaal is. Hier ligt de hele premisse: het trainings- en leerproces van ChatGPT is niet gebonden aan hardcore spelregels, zoals een schaakmachine dat is.

Steven Abreu, een onderzoeker van de Rijksuniversiteit Groningen, verduidelijkt dat wat goed werkt voor het voorspellen van de volgende token in taal, is om “veel opties open te houden”, en dan “de meest waarschijnlijke optie” te selecteren. Maar een LLM-model leert niet om sommige opties te ontkrachten, het kent alleen een lagere waarschijnlijkheid toe aan opties die minder vaak voorkomen. Is het uiteindelijk, alles in aanmerking genomen, juist om te stellen dat ChatGPT daadwerkelijk schaakt? In strikte zin, nee. ChatGPT reageert op taal die wij, als mensen, begrijpen als gerelateerd aan het spel, zonder enig concept van het gespeelde spel.

Leert ChatGPT uiteindelijk ooit goed schaken?

Zowel prof. Kanoulas als Abreu geloven dat ChatGPT, indien zij de nodige tijd krijgen, volgens de regels zou kunnen leren schaken. “Ik geloof dat LLM’s kunnen worden getraind om goed te schaken”, stelt Abreu. Dit zou volgens hem kunnen gebeuren via Reinforcement Learning through Human Feedback, een proces waarmee ChatGPT is getraind, “waarbij mensen annoteren welke antwoorden op een vraag het meest geschikt zijn en ChatGPT dan geleidelijk leert om beter te worden in het voeren van gesprekken”, legt Abreu uit. Een andere mogelijkheid is de AI af te stemmen op bestaande schaakpartijen om de beste zetten te voorspellen.

Of men zou ChatGPT kunnen trainen om te schaken als een schaakmachine. Er zijn veel manieren waarop dit zou kunnen gebeuren. Volgens prof. Kanoulas speelt ChatGPT in dit stadium misschien niet zo goed als een schaak-AI, omdat het “niets weet over beloningen, niets weet over wat het betekent om bijvoorbeeld de Dame te slaan”. Maar als het vaak genoeg ziet dat mensen bij bepaalde gelegenheden geneigd zijn de Dame te pakken, zal het dat ook gaan doen.

“De kans wordt dan groter dat het zou ‘begrijpen’ – niet omdat het zelf de beloning kan berekenen, maar omdat de mensen dat in hun hoofd deden en de schaak-AI in zijn systeem – dat dit logisch is”. Kortom, hij weet niet waarom het zo is dat hij de dame moet slaan, noch hoe dat de toekomst zal beïnvloeden, want de AI weet niets over winnen. Of verliezen.

Het komt uiteindelijk altijd neer op een antwoord met een hoge waarschijnlijkheid. Intussen blijft het debat rond nieuwe technologieën en wetenschappelijke methoden op het gebied van kunstmatige intelligentie voortgaan. Concepten als “neurosymbolische kennis” zouden een revolutie kunnen betekenen voor machinaal leren. Of misschien ook niet. De tijd – en het onderzoek – zal het uitwijzen. Voorlopig kunnen we lachen om ChatGPT’s onvermogen om tactieken en berekeningen uit te werken.