Forschende der Technischen Universität Berlin (TU Berlin), des Fraunhofer Heinrich-Hertz-Instituts (HHI) und der Singapore University of Technology and Design untersuchten kürzlich, wie verschiedene KI-Systeme zu ihren Ergebnissen kommen. Denn bislang war es der Wissenschaft meist verborgen, ob es sich wirklich um eine intelligente Lösung oder nur um einen statistisch erfolgreichen Weg handelte. Unter dem Aspekt, dass KI nicht nur als digitaler Sprachassistent oder Übersetzer genutzt wird, sondern sie auch im Bereich der medizinischen Diagnostik sowie des autonomen Fahrens eingesetzt wird, ist ein Blick auf die Funktionsweise der Lernalgorithmen ein relevanter Faktor.

Explainable AI

Für ihre Arbeit entwickelten die Forscher ein Verfahren, anhand dessen sie KI Systeme analysieren und quantifizieren können. „Diese sogenannte ‚explainable AI’ [erklärbare Künstliche Intelligenz] ist einer der wichtigsten Schritte für die praktische Anwendung und Verbreitung von KI”, so Dr. Klaus-Robert Müller, Professor für Maschinelles Lernen an der TU Berlin: “Insbesondere in der medizinischen Diagnostik oder in sicherheitskritischen Systemen dürfen wir keine KI-Algorithmen mit unsicheren Problemlösungsstrategien oder sonstige KI-Schummel-Kandidaten einführen.”

Wichtigste Voraussetzung für diese spezielle, automatisierte Technologie ist eine von der TU Berlin und dem HHI entwickelte Technik namens „Layer-wise Relevance Propagation” (LRP). Diese macht sichtbar, aufgrund welcher Kriterien KI-Systeme Entscheidungen treffen.

Als Weiterentwicklung der LRP-Technologie gilt die „Spectral Relevance Analysis” (SpRAy). Erst mit ihr wird das breite Spektrum der erlernten Entscheidungsverhalten identifiziert und quantifiziert. Ob naive Problemlösung, Schummel-Strategie oder hochelaborierte, intelligente und strategische Entscheidung – die Wissenschaftler stellten verschiedene KI-Algorithmen auf die Probe. So konnten auch bei sehr großen Datensätzen unerwünschte Lösungen ausgemacht werden.

Dazu Dr. Wojciech Samek, Gruppenleiter am Fraunhofer HHI: „Wir waren sehr erstaunt über die große Bandbreite der gelernten Problemlösungsstrategien. Selbst moderne KI-Systeme haben nicht immer einen aus menschlicher Perspektive sinnvollen Lösungsweg gefunden, sondern nutzten bisweilen sogenannte ‚Clever-Hans-Strategien’.”

Der Kluge Hans (Clever Hans) war ein Pferd des Schulmeisters und Mathematiklehrer Wilhelm von Osten, das angeblich rechnen und zählen konnte. In den Jahren um 1900 galt Hans als wissenschaftliche Sensation. Denn in 90 Prozent der Fälle beantwortete der feinfühlige Orlow-Traber durch das Klopfen mit einem Huf oder durch Nicken beziehungsweise Schütteln des Kopfes zum Beispiel arithmetische Aufgaben richtig. Später stellte sich heraus, dass Hans zwar nicht rechnen konnte, aber er seine richtige Antwort aus der Körperreaktion des Fragestellers ableitete.

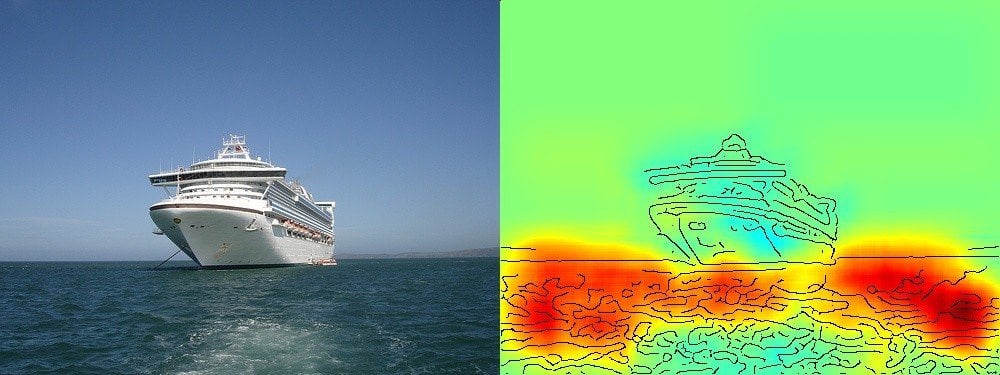

©Nature Communications/CC BY

Lösungsstrategien, die denen des kleveren Hans entsprechen, konnten die Forscher um Klaus-Robert Müller und Wojciech Samek auch bei KI-Systemen finden. So verfolgte zum Beispiel eines, das sogar vor einigen Jahren mehrere internationale Wettbewerbe zur Klassifikation von Bildern gewonnen hatte, eine aus menschlicher Sicht naive Lösungsstrategie: Es klassifizierte Bilder vorwiegend anhand des Kontextes. Dabei wurden zum Beispiel Bilder der Kategorie „Schiff” zugeordnet, wenn viel Wasser im Bild zu sehen war. Andere Bilder wurden als „Zug” klassifiziert, wenn Schienen vorhanden waren. Wieder andere Bilder wurden anhand des Copyright-Schriftzuges der richtigen Kategorie zugeordnet. Die eigentliche Aufgabe, nämlich Schiffe oder Züge zu erkennen, hat dieses KI-System nicht gelöst. Doch immerhin: die Mehrzahl der Bilder konnte es im Endeffekt korrekt klassifizieren.

Auch die sogenannten “tiefen neuronalen Netzwerke” nutzen diese Art der fehlerhaften Lösungsstrategie. Denn sie stützen ihre Klassifikations-Entscheidung zum Teil auf Artefakte, die während der Präparation von Bildern entstanden, aber mit dem eigentlichen Bildinhalt gar nichts zu tun haben.

Naive KI für die Praxis unbrauchbar

„Solche KI-Systeme sind für den praktischen Einsatz völlig unbrauchbar. Ihr Einsatz in der medizinischen Diagnostik oder in sicherheitskritischen Bereichen birgt sogar enorme Gefahren”, warnt Klaus-Robert Müller: „Es ist durchaus denkbar, dass ungefähr die Hälfte der aktuell eingesetzten KI-Systeme implizit oder explizit solche ‚Clever Hans’-Strategien nutzen. Es ist Zeit, das systematisch zu überprüfen, damit sichere KI-Systeme entwickelt werden können.”

Mit der neuen Technik konnten aber auch KI-Algorithmen identifiziert werden, die unerwartet „intelligente” Strategien anwandten. Dazu gehören Systeme, die zum Beispiel in der Lage sind, die Atari-Spiele „Breakout” – hier wird mit einem virtuellen Schläger der Ball so gelenkt, dass er die am oberen Bildschirmrand erscheinenden Bauklötze wegschießt –, und „Pinball” (virtuelles Flipperspiel) zu spielen.

„Hier haben die KI-Systeme ganz klar das Konzept des Spiels ‚verstanden’ und einen intelligenten Weg gefunden, zielgerichtet und risikoarm sehr viele Punkte zu sammeln. Dabei schlägt das System bisweilen Wege ein, die ein echter Spieler nicht nutzen würde”, so Wojciech Samek.

Die automatisierte Technik steht als Open Source allen Wissenschaftlern und Wissenschaftlerinnen zur Verfügung. „Wir sehen unsere Arbeit als einen wichtigen ersten Schritt, KI-Systeme in Zukunft robuster, erklärbar und sicher zu machen. Denn das ist die wesentliche Voraussetzung für den Einsatz von KI überhaupt”, so Klaus-Robert Müller.

Dieser Artikel könnte Sie auch interessieren

Gratwanderungen: Künstliche Intelligenz in der Medizin

Menschliches Gehirn inspiriert Forscher bei Künstlicher Intelligenz