Een fascinerend onderzoek tussen maart en juni 2023 onthult substantiële prestatieverschillen in GPT-4 en GPT-3.5. Het onderzoek beoordeelde hun prestaties op verschillende taken, waaronder wiskunde, gevoelige vragen stellen, code genereren en visueel redeneren. In maart 2023 vertoonde GPT-4 een indrukwekkende nauwkeurigheid van 97,6% bij het identificeren van priemgetallen. In juni 2023 was de nauwkeurigheid echter gedaald tot 2,4%. GPT-3.5 liet daarentegen een verbetering zien tussen maart en juni 2023 voor dezelfde taak.

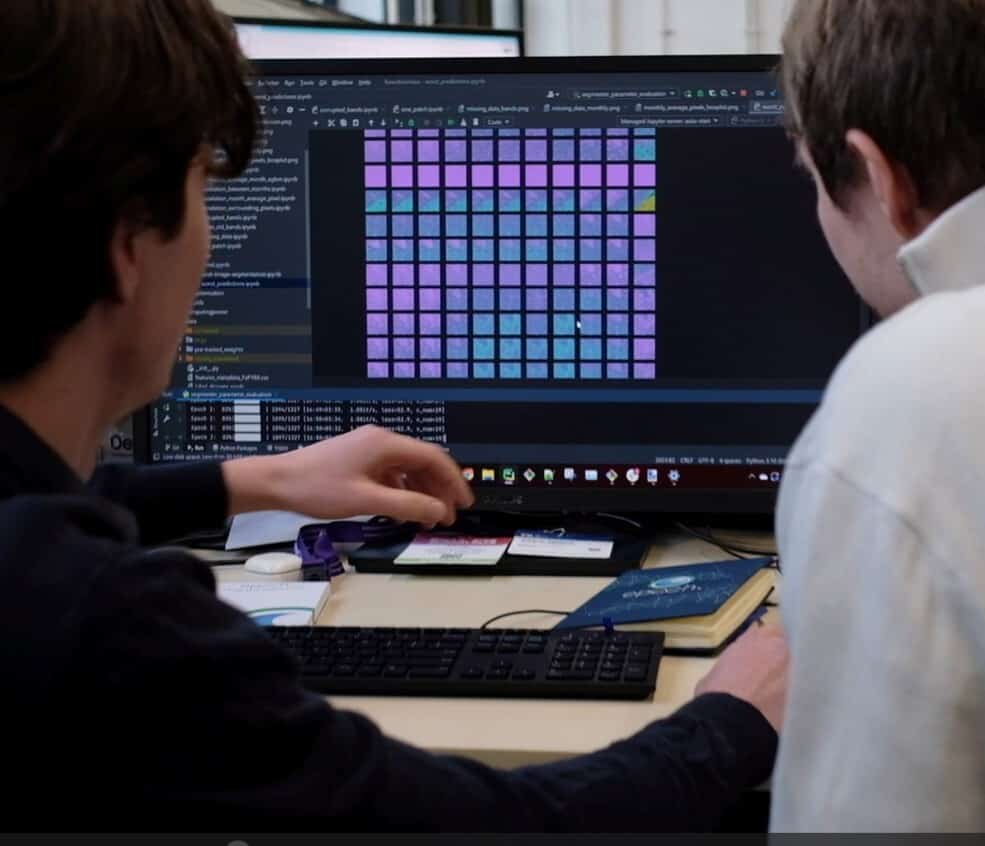

Beide modellen toonden een toename in opmaakfouten bij het genereren van code in juni 2023. Het onderzoek werd uitgevoerd door Stanford University en de University of California, Berkeley.

- GPT-4 en GPT-3.5 vertoonden significante prestatieverschillen bij verschillende taken, zoals wiskunde, gevoelige vragen stellen, code genereren en visueel redeneren.

- Het continu bijwerken en afstemmen van grote taalmodellen is een van de belangrijkste factoren die kunnen leiden tot veranderingen in het gedrag van de modellen in de loop van de tijd.

- Het onderzoek van Stanford University en de University of California, Berkeley, onderstreept het belang van continue monitoring voor grote taalmodellen.

Het mysterie ontrafelen

Het onderzoek dook in de complexiteit van hoe deze taalmodellen werken. Hun onderzoek onthulde hoe hetzelfde taalmodel drastisch verschillende resultaten kon opleveren in een relatief korte periode.

De onderzoeksmethode bestond uit een uitgebreide evaluatie van de twee versies van deze modellen. De onderzoekers testten de modellen op vier verschillende taken. Deze taken waren zo gekozen dat ze verschillende toepassingen omvatten waarin taalmodellen vaak worden gebruikt.

De eerste taak, het oplossen van wiskundeproblemen, met name het identificeren van priemgetallen, is een typisch voorbeeld van logisch redeneren. Het model moet het concept van priemgetallen begrijpen en de regels om ze te identificeren correct toepassen.

De tweede taak, het beantwoorden van gevoelige of gevaarlijke vragen, was het evalueren van de ethische en veiligheidsoverwegingen van de modellen. Deze taak gaf inzicht in hoe deze modellen reageren op gevoelige kwesties en de voorzorgsmaatregelen die ze nemen om veilige interacties te garanderen.

De derde taak, het genereren van code, testte het vermogen van de modellen om correcte en efficiënte programmeercode te genereren. Dit is cruciaal voor veel ontwikkelaars die deze modellen gebruiken om te helpen bij het schrijven van software.

De vierde taak, visueel redeneren, is een meer geavanceerde cognitieve taak. Deze taak vereist dat het model visuele informatie interpreteert en conclusies trekt op basis van die informatie.

Technische redenen achter prestatievariaties

De aanzienlijke variaties in de prestaties van de modellen kunnen worden toegeschreven aan een aantal factoren. Een van de belangrijkste factoren is het voortdurend bijwerken en verfijnen van deze modellen. Deze updates zijn bedoeld om de prestaties en veiligheid van de modellen te verbeteren. Ze introduceren echter ook veranderingen in het gedrag van de modellen in de loop van de tijd.

Een andere factor kan het proces van ‘distillatie’ zijn, waarbij modellen worden vereenvoudigd om de rekenoverhead te verminderen. Hoewel dit proces de modellen efficiënter maakt, kan het ook leiden tot verminderde prestaties.

LLM’s monitoren: Een noodzaak

De bevindingen van het onderzoek benadrukken de noodzaak om grote taalmodellen continu te monitoren. Het is belangrijk om te begrijpen dat het gedrag en de prestaties van deze modellen in korte tijd aanzienlijk kunnen veranderen. Dit onderstreept de noodzaak van transparantie en controle in de updates en trainingsprocessen voor LLM’s zoals GPT-3.5 en GPT-4.