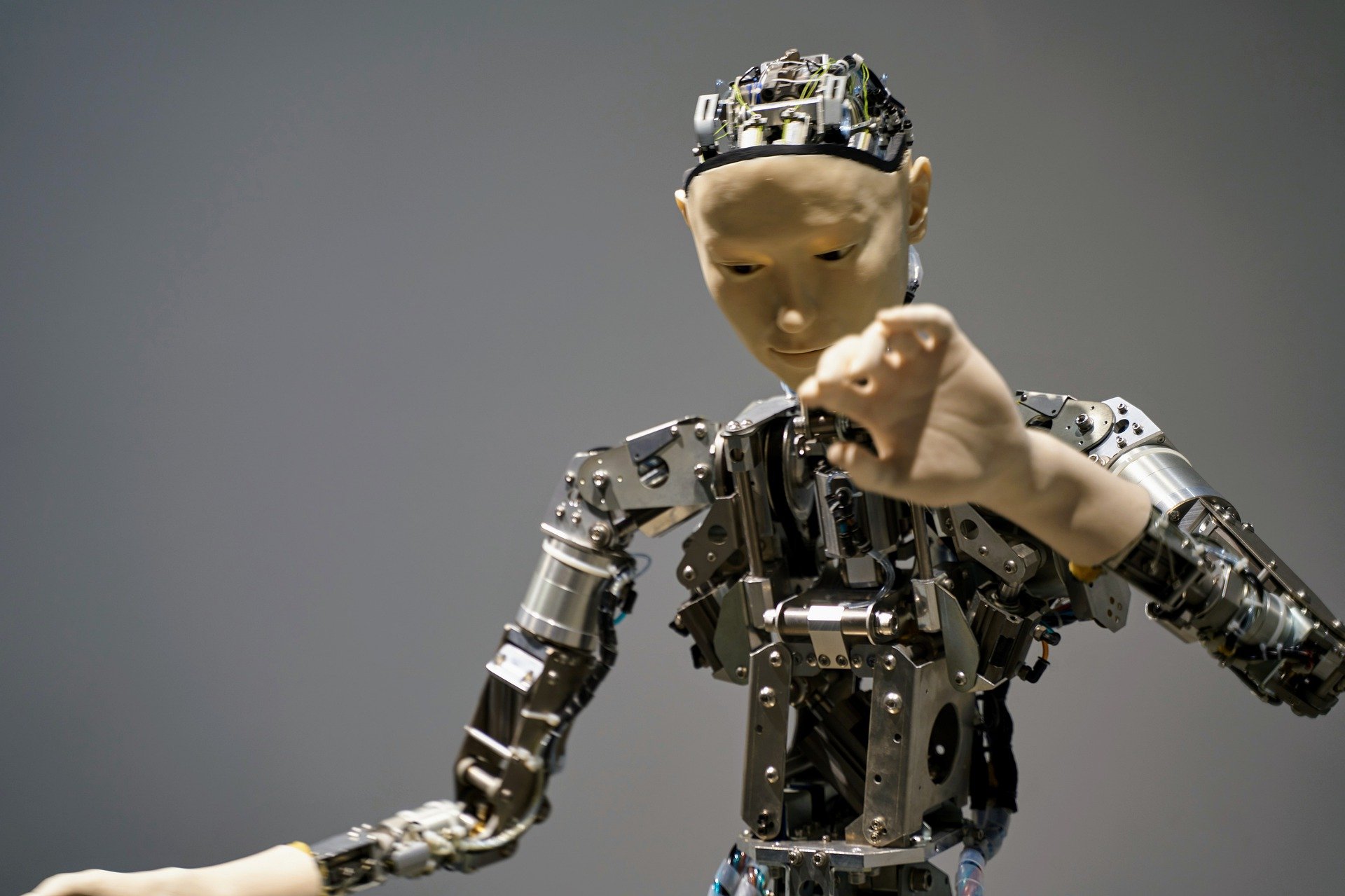

Wat zouden machines die in staat zijn tot moreel gedrag in de praktijk betekenen? De Zweedse fictieserie Real Humans geeft een interessante invulling aan deze vraag: ‘hubots’ – samentrekking van ‘human’ en ‘robot’ – leven samen met mensen en komen in opstand om meer rechten te eisen. Mensen moeten niet alleen respect voor hen hebben, maar ook hun belangen serieus nemen. Dit type robot kan ook moreel en juridisch verantwoordelijk gesteld worden. Als zou blijken dat robots ooit moreel beter (minder feilbaar) zijn dan wij, dan zouden ze in principe onze ‘morele mentors’ kunnen worden.

Real Humans is uiteraard fictie en levert een interessant gedachte-experiment maar niet meer dan dat. Een programma dat ‘goed’ werkt, betekent dat het doet wat het moet doen. Hoe zit het met morele goedheid in machines? Kunnen we dat überhaupt ‘programmeren’? De technische, functionele aspecten vormen al een hele uitdaging. Bovendien is er niet zomaar een ‘perfecte morele blauwdruk’ voorhanden die de data bevat waarmee we een machine eenvoudigweg kunnen trainen. Mensen zijn immers moreel feilbaar.

Geen consensus

Er is ook geen consensus over welke ethische theorie de basis moet vormen voor ethische standaarden; filosofen discussiëren daar al eeuwen over. Moet het AI-systeem gehoorzamen aan morele regels of moet het zo handelen dat het geluk van het grootste aantal mensen vergroot?

In het eerste geval (gehoorzamen aan morele regels) moet de machine geprogrammeerd worden met expliciete regels waaraan die moet gehoorzamen om tot een moreel besluit te komen. Laten we die regel simpel houden: de eeuwenoude gulden regel ‘Doe een ander niet aan wat je zelf niet wil’. De regel mag dan al simpel zijn, de toepassing ervan is bijzonder complex. De computer moet dan namelijk in staat zijn om zélf te bepalen wat die wel en niet wil, in diverse hypothetische contexten, en daarbij een inschatting kunnen maken van de gevolgen van andermans daden op zichzelf. Ook als de computer niet over échte empathie beschikt, dan nog moet die op zijn minst het ‘inlevingsvermogen’ hebben om de gevolgen van de eigen handelingen op anderen te berekenen, om in te schatten in hoeverre de machine zou wensen om zelf zo behandeld te worden. En daarbij moet het systeem ook nog rekening houden met de verschillen in individuele opvattingen en voorkeuren.

Ethische theorie

En valt dat überhaupt te vatten in wiskundige termen? Misschien is het ‘makkelijker’ om het systeem te voeden met een ethische theorie die focust op het vergroten van het geluk van het grootste aantal mensen. Om die ethische theorie (utilitarisme of consequentialisme) in een machine te implementeren, moeten de effecten van een handeling op elk lid van de morele gemeenschap een numerieke waarde krijgen. Maar het is onmogelijk om dit in real-time voor elke handeling in de wereld te doen, vooral omdat de gevolgen van elke handeling weer tot nieuwe gevolgen leiden. Op zich kun je het rekenprobleem beperken door een grens op te leggen, waarboven geen verdere inschatting van gevolgen meer nodig is. Ook dat is onwaarschijnlijk complex en bovendien kan er net buiten die grens misschien ongelooflijk veel lijden en pijn veroorzaakt worden, wat we toch als een moreel verwerpelijke daad zouden beschouwen.

Net zoals bij Real Humans bevatten ideeën over ‘morele machines’ interessante gedachte-experimenten. Maar voorlopig niet meer dan dat.

Over deze column:

In een wekelijkse column, afwisselend geschreven door Bert Overlack, Mary Fiers, Peter de Kock, Eveline van Zeeland, Lucien Engelen, Tessie Hartjes, Jan Wouters, Katleen Gabriels en Auke Hoekstra, probeert Innovation Origins in een wekelijkse column te achterhalen hoe de toekomst eruit zal zien. Deze columnisten, soms aangevuld met gastbloggers, werken allemaal op hun eigen manier aan oplossingen voor de problemen van deze tijd. Zodat morgen beter wordt. Hier lees je alle vorige afleveringen.