Het is voor veel mensen een eng idee. Een intelligente machine die de diagnose van je medische probleem stelt of een chirurgische robot die je opereert. En er zijn meer problemen. Zo is de term kunstmatige of artificiële intelligentie (AI) een vaag begrip. Dat leidt in het publieke debat tot het spookbeeld van een onvoorspelbare macht die zich op een dag tegen ons zou kunnen keren. In feite gaat het echter om wiskundigen die algoritmen ontwikkelen. En zij weten meestal precies wat zij berekenen, aldus Duitse en Oostenrijkse medici en wetenschappers afgelopen maand in een online discussie, georganiseerd door de Universiteit van Wenen.

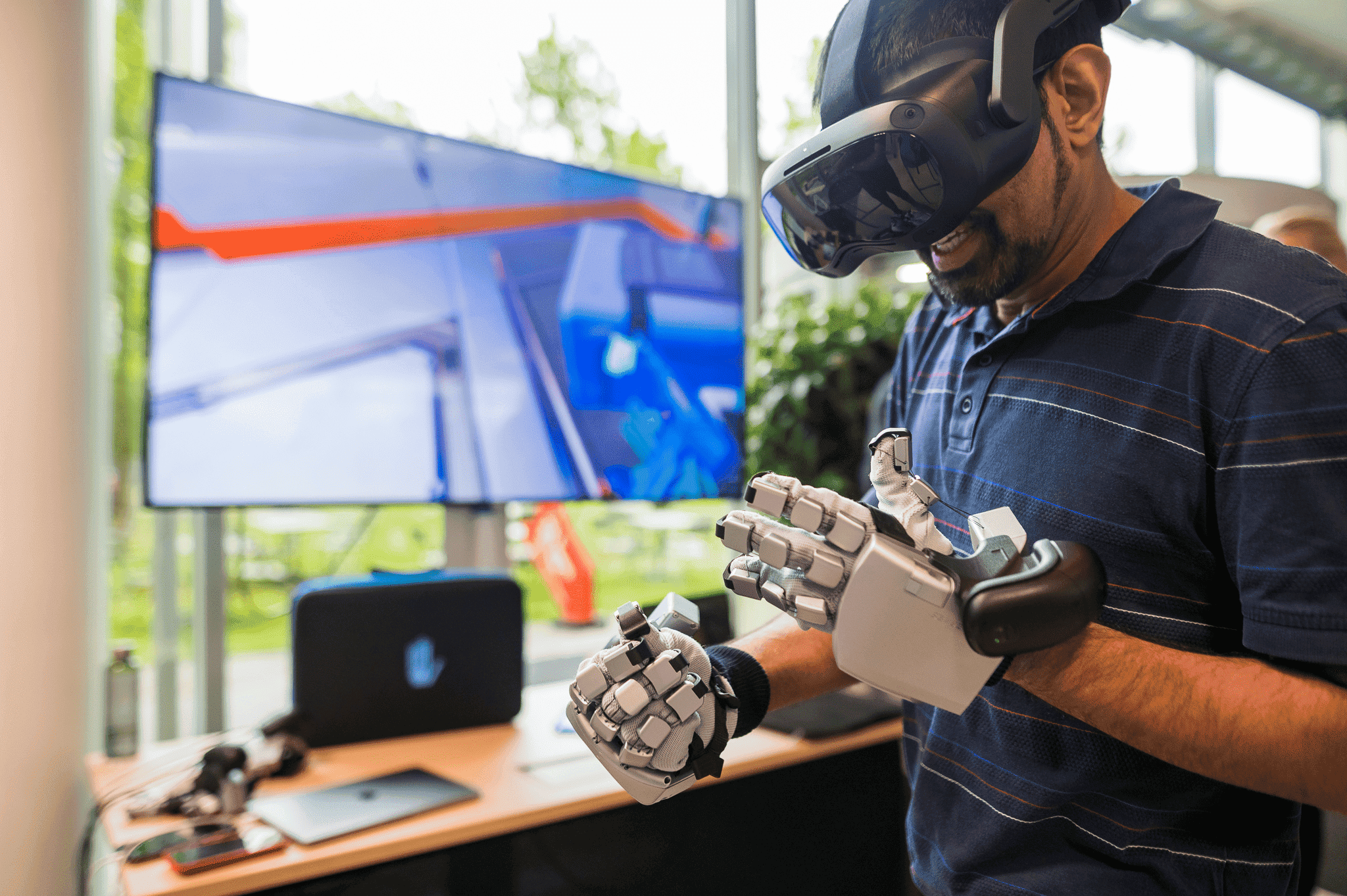

In deze editie van de zogenoemde Kaiserschild Lectures stelden de wetenschappers en medici dat het geenszins de bedoeling is dat kunstmatige intelligentie artsen vervangt. In onderzoekskringen wordt uitgegaan van de complementariteit van mens en machine. Er bestaan immers al human-in-the-Loop-systemen, waarin mensen machines ondersteunen in moeilijke of onbekende situaties.

Kunstmatige intelligentie wordt al veel gebruikt in de geneeskunde. Een arts kan tijdens een onderzoek een app raadplegen ter ondersteuning van zijn diagnose. Er zijn ook andere vormen van AI in de medische wereld. Dat loopt van geautomatiseerde toewijzing van afspraken, telegeneeskunde en videotelefonie, tot apps die patiënten helpen hun klachten te definiëren zodat ze gericht medische hulp kunnen zoeken.

“Wat tegenwoordig onder kunstmatige intelligentie in de geneeskunde valt, zijn patroonherkenningstechnieken. Algoritmen die patronen kunnen herkennen en classificeren. Waarbij zelfs voorspellende patronen worden herkend. De huidige standaardmethoden bestaan al acht à negen jaar. Deze zijn gebaseerd op neurale netwerken,” legt Horst Hahn van het Fraunhofer Institut für Digitale Medizin MEVIS in Bremen uit.

Ongewenste gevolgen

“De geldigheid van de gevonden patronen of correlaties is afhankelijk van de onderliggende gegevens. Zelfs in de geneeskunde worden gegevens niet altijd zonder vooringenomenheid verzameld”, erkent data-miningdeskundige, professor Claudia Plant van het Institut für Informatik aan de Universiteit van Wenen. Het is bijvoorbeeld bekend, stelt zij, dat vrouwen, evenals bepaalde etnische groepen en genetische subgroepen, ondervertegenwoordigd zijn in medische databanken.

“Nog problematischer is dat we eigenlijk niet weten waar we naar moeten zoeken”, zegt Plant. “Onderzoek hiernaar staat nog in de kinderschoenen.” Hahn wijst erop dat kunstmatige intelligentie meer in het algemeen ongewenste gevolgen voor de samenleving kan hebben. Want als machines sneller dan mensen voorspellingen kunnen doen op basis van omvangrijke, hoogdimensionale data, kan dit er volgens hem gemakkelijk toe leiden dat mensen details uit het oog verliezen en beslissingen overlaten aan de machine. “Dan val je regelrecht in de valkuilen van kunstmatige intelligentiesystemen. Als bijvoorbeeld gegevens niet kloppen en de subgroep niet goed genoeg getraind is, dan zijn de antwoorden niet in orde of hebben ze precies de bias die Plant aankaart”, zegt Hahn.

Wanneer machines sneller dan mensen voorspellingen kunnen doen op basis van hoogdimensionale data, is het voor mensen gemakkelijk om de details uit het oog te verliezen en beslissingen aan de machine over te laten.

Dr. Horst Hahn, hoofd Fraunhofer Institut für digitale Medizin MEVIS, Bremen

Databescherming

Kunstmatige intelligentie is gebaseerd op zeer grote hoeveelheden gegevens die in Open Data-platforms zijn verzameld. Onderzoekers zijn afhankelijk van deze bronnen. Tegelijkertijd bestaat het gevaar van identificeerbaarheid van de patiënt. Vooral wanneer het gaat om zeldzame ziekten, het koppelen van verschillende online beschikbare gegevensbronnen, of zelfs het per ongeluk niet wissen van een datum. Hahn doet onderzoek naar een project waarbij de gegevens blijven waar ze worden gegenereerd, waar ze worden geanalyseerd en waar de analyses worden gecoördineerd.

Het is een vorm van federated learning, of multicentrisch machinaal leren, waarmee algoritmen kunnen worden getraind om gegevens privé te houden. Hij is van mening dat deze aanpak des te noodzakelijker is nu steeds complexere vragen worden gesteld. Zoals de relatie van een bepaalde genetische variant tot patronen die we zien in beeldvorming en de mogelijke ziekteprogressie daaruit.

Berekenbare kunstmatige intelligentie

Er is nog een ander aspect dat op langere termijn tot een kenniskloof kan leiden. Kunstmatige intelligentie kan zeer goede beslissingen nemen, maar kan zichzelf niet altijd verklaren. Dit betekent dat causaliteit en correlatie niet afzonderlijk kunnen worden waargenomen, zoals de wetenschapsfilosofie vereist. Volgens Hahn doen onderzoekers over de hele wereld hier onderzoek naar.

Er zijn al verschillende methoden. Die moeten alleen nog in praktijk worden gebracht. Zo is er de mogelijkheid om soortgelijke gevallen in de databank op te vragen om zekerheid te krijgen. Bovendien moet het mogelijk zijn te evalueren waar het neurale netwerk onveilig is. “Er is een heel scala aan benaderingen. Ik denk dat we op een dag in staat zullen zijn om in zekere zin met deze systemen te praten. Dat we in staat zullen zijn om hen te vragen: hoe weet je dit? En dat ze ook zullen leren om te antwoorden: ‘ik weet het niet’,” aldus Hahn.

Overdreven voorwaarden

Hoogleraar Jens Meier die de Leerstoel voor anesthesie en IC bekleedt aan de Universiteit van Linz, denkt dat de roep om verklaarbare kunstmatige intelligentie wel eens overdreven zou kunnen zijn. “We kennen het mechanisme van de geneeskunde niet voldoende in detail. We weten alleen uit observatie hoe dingen werken. Causaliteit in de geneeskunde is iets wat we graag aan de buitenwereld verkopen. Maar als we eerlijk zijn, hebben we vaker alleen waarnemingen.”

Hij kreeg daarbij steun van Barbara Prainsack van het Institut für Politikwissenschaft aan de Universiteit van Wenen. Zij zegt dat ervaringskennis niet altijd expliciet wordt verwoord. “Maar dat betekent niet dat beslissingen verkeerd of slecht zijn”, zegt ze. Prainsack: “Meten we hier dan met twee maten en zeggen we dat de machine alles moet kunnen verklaren en de mens niet?”

Vormgeving van de interactie

De maatschappelijke verantwoordelijkheid ligt in het correct ontwerpen van de interactie tussen mens en machine, vat Prainsack samen. Machines worden niet moe en kunnen grote hoeveelheden gegevens verwerken. Het is echter niet alleen een kwestie van informatie overbrengen. Contextuele kennis en communicatie kunnen niet van machines worden verwacht.

Als een taak mensen vereist, dan moeten processen niet worden geautomatiseerd, ook al is dat technisch mogelijk.

Dr. Barbara Prainsack, Institut für Politikwissenschaften, Universiteit van Wenen

Plant moedigt een intensivering van het onderzoek naar kunstmatige intelligentie in de geneeskunde aan. Met het verklaarde doel deze te gebruiken ten voordele van de mens. Wereldwijd gaat het meeste geld voor onderzoek naar kunstmatige intelligentie naar de militaire sector. En vaak in landen met een twijfelachtig democratisch bestel. Plant: “Ik denk dat we de moed moeten hebben om onderzoek te doen naar kunstmatige intelligentie in de geneeskunde dat overeenstemt met de Europese waarden. En dat dan ook doen voor andere onderwerpen.”

Ook interessant: Wet in de maak: Europese Commissie wil lijst superriskante AI