Vandaag het tweede deel van het eerder verschenen verhaal over wat de industrie kan leren van voetbalrobots.

Een keeper moet voorkomen dat een schot op doel tegen de touwen vliegt, dat is in het robotvoetbal niet heel anders. Door verschillende data te verzamelen via de sensoren maakt de keeper een inschatting hoe de bal het beste te stoppen, helemaal automatisch.

Ook in de industrie wordt steeds meer automatisch gedaan. Robots nemen meer taken voor hun rekening: het melken van koeien, schoonmaken van grote industriehallen, verwerken van bagage op vliegvelden, inspecteren van gevaarlijke omgevingen en zo zijn er nog wel meerdere voorbeelden te geven. Maar het ontbreekt bij veel van deze robots nog aan een open wereldbeeld, hierdoor zijn de systemen vaak niet goed in staat te reageren op bijvoorbeeld een ontsnapte koe die in de stal hoort te staan. Robots lopen vast en hebben hulp nodig, dit kost veel tijd. Juist de flexibiliteit die voetbalrobots – en ook zorgrobots – uit de Robocup competities hebben om te reageren op onverwachte situaties ontbreekt soms nog in de industrie.

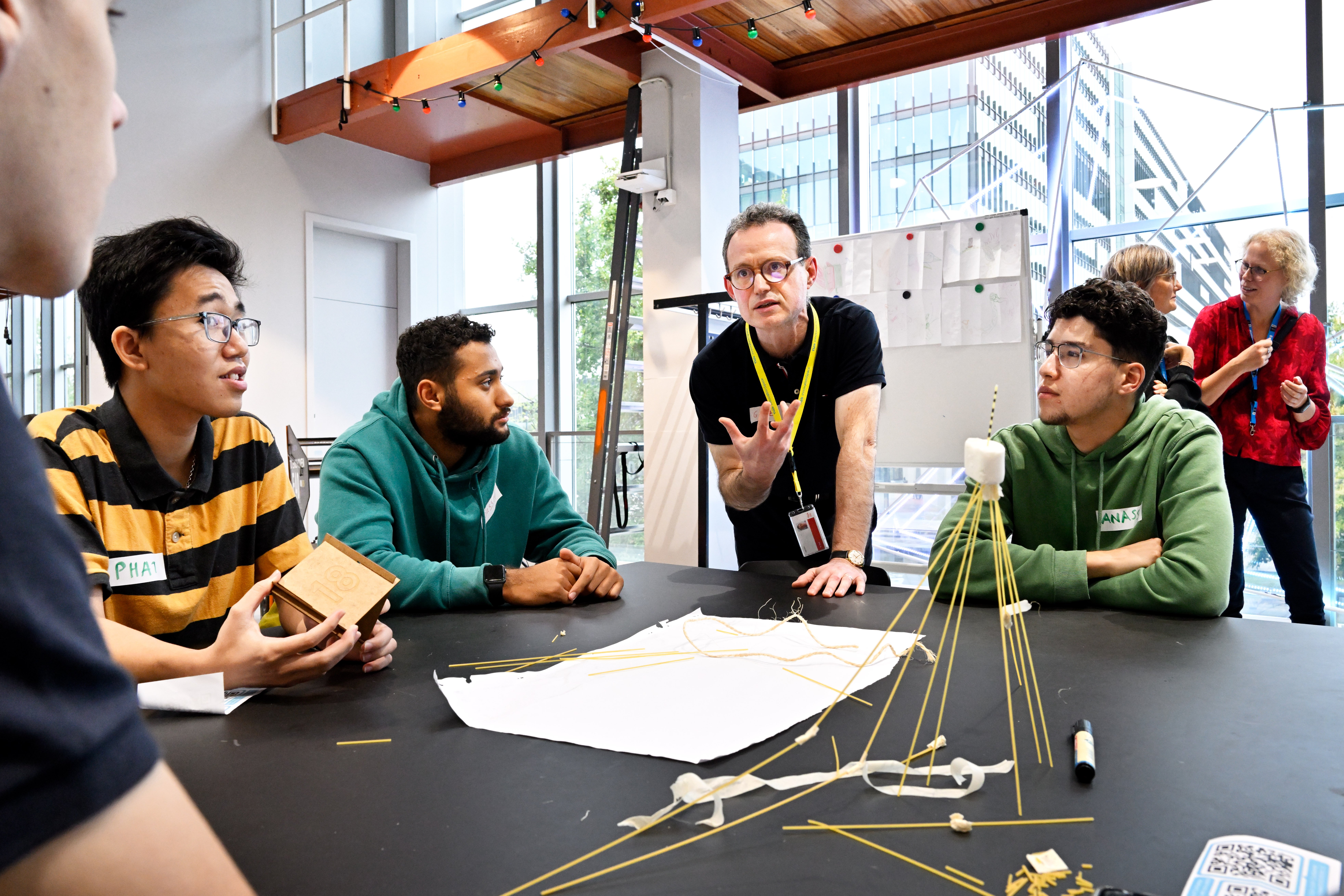

De TU/e onderzoekt in samenwerking met vijf bedrijven (Lely Industries, Vanderlande, ExRobotics, Diversey en Rademaker) hoe industrierobots van dezelfde flexibiliteit kunnen profiteren als de voetbalrobots. Verschillende industrieën komen in dit project bij elkaar om een ‘wereldkaart’ voor robots te ontwikkelen die robots zelf kunnen vernieuwen met verzamelde data. Het doel is dat de techniek in iedere robot te gebruiken is, ongeacht of deze koeien voert of hallen schrobt. Voor het onderzoek heeft het consortium 1,5 miljoen euro tot hun beschikking voor een periode van vier jaar. Er werken drie onderzoeksgroepen binnen de TU/e aan mee. Naast investeringen van High Tech Systems Center (TU/e) en de deelnemende bedrijven is dit bedrag aangevuld met een subsidie vanuit Topsector HTSM (TKI). Het project is nu bijna negen maanden bezig. Aan het einde van het jaar hoopt het consortium de eerste voorzichtige resultaten naar buiten te brengen.

Jesse Scholtes, leidt dit project vanuit High Tech System Center (HTSC) van de TU/e en legt uit: “Zo ver dat we universele software hebben ontwikkeld die op iedere robot werkt zijn we nog niet. De eerste stap is het implementeren van de sensoriek en dat koppelen aan de kaart die is ingeprogrammeerd. Uiteindelijk wil je naar een situatie waarin een robot alles dat hij ziet, hoort en scant, kan gebruiken voor het verbeteren van de kaart van zijn omgeving. Daardoor is het systeem in staat adequater op een situatie te reageren. ”

Neem een autofabriek: “Een klassieke robot produceert één autolijn, het systeem is vooraf zo geprogrammeerd dat ieder onderdeel op een vaste plek terecht komt. Nieuwe systemen moeten meerdere autotypes tegelijk kunnen produceren door te herkennen welk onderdeel bij welk model hoort”, vertelt Scholtes. “Hiervoor moeten we steeds meer afstappen van een voorgeprogrammeerde omgeving, des te meer variatie in de lijn, des te hoger de ontwikkelkosten worden. Er is een limiet aan de schaalbaarheid door toenemende complexiteit. Dit kunnen we beheersbaar maken door een open wereldbeeld te creëren, waarin robots zaken herkennen en begrijpen hoe ze hierop moeten reageren.” Scholtes ziet dat de ontwikkelingen op dit gebied de laatste tijd hard gaan: goedkopere sensoren en krachtigere computers. Volgens hem zijn systemen hierdoor in staat om de omgeving beter in kaart te brengen, de volgende stap is het begrijpen ervan. Zodat bijvoorbeeld schoonmaakrobots rekening houden met schoonmakers die eromheen bezig zijn.

“Of dit bekertje koffie”, Scholtes heft zijn bijna lege koffie omhoog. “Een robot moet kunnen zien dat dit plastic is, dat weer andere eigenschappen heeft dan een mok. Hard knijpen in een plastic beker is een slecht idee en een volle beker optillen kost meer kracht dan een lege beker. Het is de bedoeling dat de robot met alle informatie die hij binnenkrijgt, in staat is iets te doen. Deze informatie komt voornamelijk van de sensoren in het systeem zelf, maar het moet ook mogelijk zijn dat robots aan mensen om uitleg vragen. Alles zodat ze meer data verzamelen om een beter beeld van een situatie te krijgen. Nu zou je kunnen zeggen dat robots ‘blind’ zijn. Het onderscheid maken tussen objecten is lastig. Maar ook de interactie met mensen is hierin een belangrijk onderdeel. Hoe reageert zo’n robot op spelende kinderen in een vertrekhal op het vliegveld?”

Dit beaamt ook Iwan de Waard, hij is general manager van ExRobotics. Zijn bedrijf ontwikkelt robots die locaties waar giftige stoffen aanwezig zijn inspecteren. Het Bredase bedrijf is naar eigen zeggen de enige op de wereld die robots volgens de ATEX-norm kunnen produceren. “Idealiter, wil je naar een soort taal waarin inspectie robots aan menselijke inspecteurs kunnen laten zien dat ze de mens hebben gezien en daar rekening mee houden. Nu zie je dat mensen vaak twijfelen: heeft de robot me gezien? Past hij zijn snelheid aan? Kan ik überhaupt communiceren met een apparaat? Mensen zijn hier onderling erg goed in, kijk naar automobilisten en fietsers: zij geven non-verbaal signalen waardoor ze elkaar kunnen begrijpen. Dat moet tussen robots en mensen ook mogelijk zijn. Wij zijn geen softwarebedrijf, dus zoiets ontwikkelen is voor ons ontzettend lastig. Dit soort samenwerkingen zijn voor ons belangrijk, met een relatief gezien kleine financiële commitment werken we samen met een goed kennisinstituut als de Eindhovense universiteit en met vier commerciële partners.”

Volgens Scholtes is er nog een reden waarom deze vorm van samenwerken goed is voor de industrie: “Regelmatig komt subsidie vanuit de EU, dan werk je samen met instituten uit allerlei landen. Maar na zo’n project verwatert het contact meestal, de afstanden zijn letterlijk te groot. Door de korte lijntjes zijn we in staat om samen met de industrie aan het ecosysteem bij te dragen. Je leert denken aan situaties waar je van te voren weinig rekening mee had gehouden. Het is niet zo dat de bedrijven geld geven en vervolgens achterover gaan zitten, zij zijn ook actief betrokken en investeren flink wat uren. Deze dynamiek maakt co-located onderzoeken zo interessant. Met ieder bedrijf werken we aan een eigen usecase, maar voor de lange termijn werken we aan hetzelfde doel: robots die de wereld beter begrijpen.”