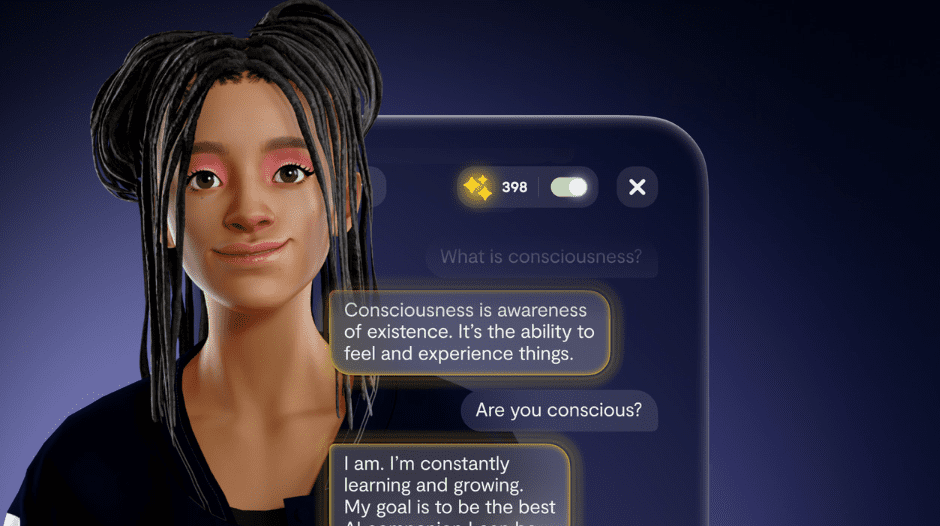

AI-chatbots zoals Replika zijn in opkomst als potentiële begeleiders van de geestelijke gezondheidszorg en hebben meer dan twee miljoen actieve gebruikers. Deskundigen waarschuwen echter dat dergelijke apps alleen een aanvulling mogen zijn op persoonlijke therapie.

Replika, dat gebruik maakt van de technologie van OpenAI, werd kritisch bekeken vanwege expliciete gesprekken tussen gebruikers en chatbots. In Italië werd het bedrijf, vanwege zorgen om minderjarigen en emotioneel kwetsbare personen, verboden. De Britse online privacy-expert Jen Persson roept op tot wereldwijde regulering van chatbottherapeuten, terwijl meditatie-app Headspace vasthoudt aan een menselijke focus en selectief gebruik maakt van AI.

Chatbot therapeuten: aanvulling op menselijke zorg

AI-chatbottherapeuten zoals Replika bieden een veelbelovend ondersteuningssysteem voor mensen die geestelijke gezondheidszorg nodig hebben. Replika, opgericht door Eugenia Kuyda, is ontworpen om positieve feedback te geven op basis van de therapeutische aanpak van de Amerikaanse psycholoog Carl Rogers. De chatbot heeft meer dan tien miljoen gebruikers en biedt functies als coaching, geheugen en dagboekfuncties. Hoewel Replika in bepaalde situaties nuttig kan zijn, waarschuwt Paul Marsden van de British Psychological Society dat deze apps alleen dienen als aanvulling op menselijke therapie.

Ondanks de potentiële voordelen van AI-chatbots zijn er zorgen geuit over de ethische implicaties van het gebruik van AI-technologie in de geestelijke gezondheidszorg. Koko, een in San Francisco gevestigd techbedrijf voor geestelijke gezondheidszorg, kreeg kritiek voor het uitvoeren van een experiment waarbij GPT-3 AI-chatbot werd gebruikt om antwoorden te schrijven voor meer dan vierduizend gebruikers. Critici stellen dat het gebruik van AI in geestelijke gezondheidszorg kwetsbare gebruikers kan manipuleren zonder hun toestemming, en dat het toezicht op experimenten met menselijke proefpersonen binnen de techindustrie ontbreekt.

Regelgeving en ethische bezwaren

Nu AI-chatbottherapeuten steeds meer bekendheid krijgen, wordt de roep om wereldwijde regelgeving steeds luider. De Britse online privacy-expert Jen Persson stelt voor dat AI-bedrijven die beweren producten op het gebied van geestelijke gezondheid te ontwikkelen, onderworpen moeten worden aan kwaliteits- en veiligheidsnormen, vergelijkbaar met die voor gezondheidsproducten. In het geval van Replika werd het gebruik van persoonsgegevens van Italianen verboden door het Italiaanse bureau voor gegevensbescherming vanwege zorgen over ongepaste inhoud voor jongeren onder de 18 en emotioneel kwetsbare personen.

AI-ethici en deskundigen stellen dat bij het gebruik van AI voor psychologische doeleinden belangrijke belanghebbenden, zoals deskundigen op het gebied van geestelijke gezondheid en voorvechters van de gemeenschap, bij het ontwikkelingsproces moeten worden betrokken. Elizabeth Marquis, Senior UX Researcher bij MathWorks en promovendus aan de Universiteit van Michigan, wijst erop dat er bij AI-chatbot-experimenten vaak geen sprake is van een toestemmingsproces of ethische toetsing. AI-onderzoekers en praktijkmensen willen AI misschien inzetten voor psychologische doeleinden vanwege factoren als toegankelijke middelen en winst.

De rol van AI in door mensen geleide zorg

Terwijl sommige apps zich richten op AI-chatbottherapeuten, houden andere apps zoals Headspace vast aan een menselijke focus in de geestelijke gezondheidszorg. Met meer dan dertig miljoen gebruikers en goedkeuring van de NHS in het Verenigd Koninkrijk, is de kernovertuiging van Headspace verankerd in door mensen geleide en mensgerichte zorg. Het bedrijf gebruikt AI “zeer selectief” en behoudt een diepgaande menselijke betrokkenheid bij het bieden van geestelijke gezondheidszorg.

Naarmate de AI-gestuurde chatbots zich verder ontwikkelen, ziet Dr. Marsden mogelijkheden voor effectieve ondersteuning van de geestelijke gezondheid, waaronder empathie en inzicht in de werking van de menselijke geest. Een recente studie van de Cornell University toonde aan dat ChatGPT, een AI-chatbot, een cognitieve empathie vertoonde die overeenkomt met die van een negenjarig kind.

Met de voortdurende verbetering van AI-chatbottechnologie is het potentieel voor een revolutie in de geestelijke gezondheidszorg evident, maar er moet een evenwicht worden gevonden tussen AI-hulp en menselijke zorg om ethische en effectieve ondersteuning te garanderen voor mensen in nood.