Gollem in ‘The Lord of the Rings’, Thanos in de ‘Avengers’ en Snoke in ‘Star Wars’ zijn wonderen uit de wereld van motion-capture, een filmtechniek die de bewegingen van een acteur volgt en deze als het ware vertaalt naar computeranimatie en daarmee een levensecht aandoende personage op te wekken.

Motion-capture zonder verkleedpartij

Motion-capture is niet beperkt tot alleen het grote scherm, maar strekt zich uit tot de wetenschap. Gedragswetenschappers hebben vergelijkbare instrumenten ontwikkeld en gebruikt om de houding en beweging van dieren onder verschillende omstandigheden te bestuderen en te analyseren.

Maar daarbij rijst een probleem. Bij motion-capture van mensen draagt iemand een tamelijk ingewikkelde uitrusting met markers die de computer laten weten waar elk deel van het lichaam zich in de driedimensionale ruimte bevindt. Maar dieren hebben de neiging zo’n verkleedpartij niet op prijs te stellen.

Het laboratorium van de jonge Amerikaanse neurowetenschapper heeft een vergaande software werkset ontwikkeld onder de naam DeepLabCut

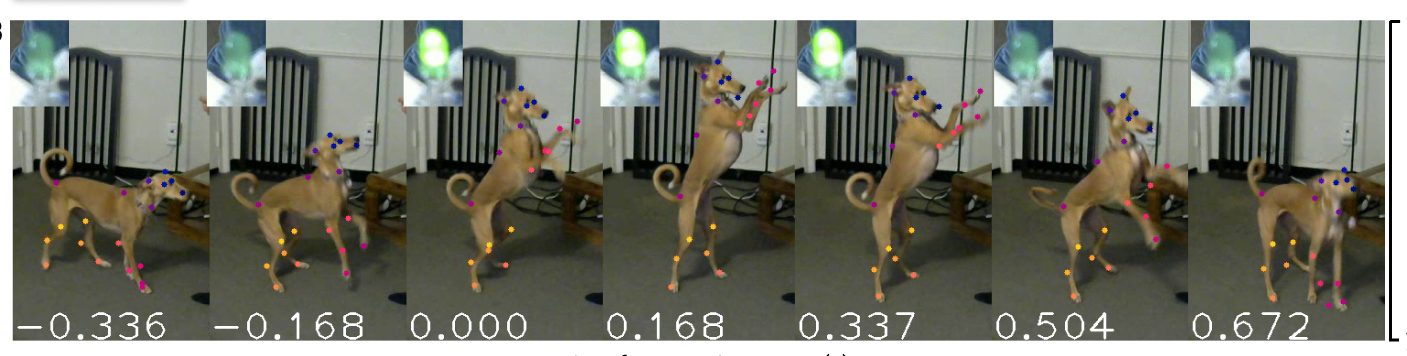

Om dat probleem op te lossen, combineren wetenschappers motion-capture met deep learning, een methode die een computer in wezen laat leren hoe hij een taak optimaal kan uitvoeren, bijvoorbeeld het herkennen in videobeelden van specifiek punten. Het idee is om de computer te leren de bewegingen of houding van een dier te volgen en zelfs te voorspellen zonder de noodzaak van het aanbrengen van markers.

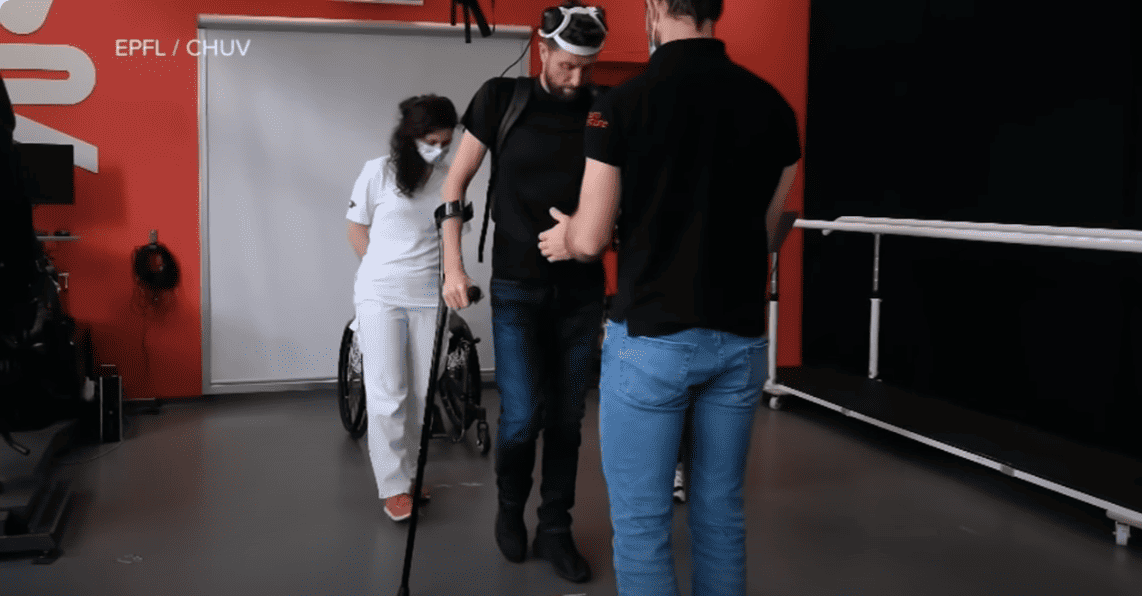

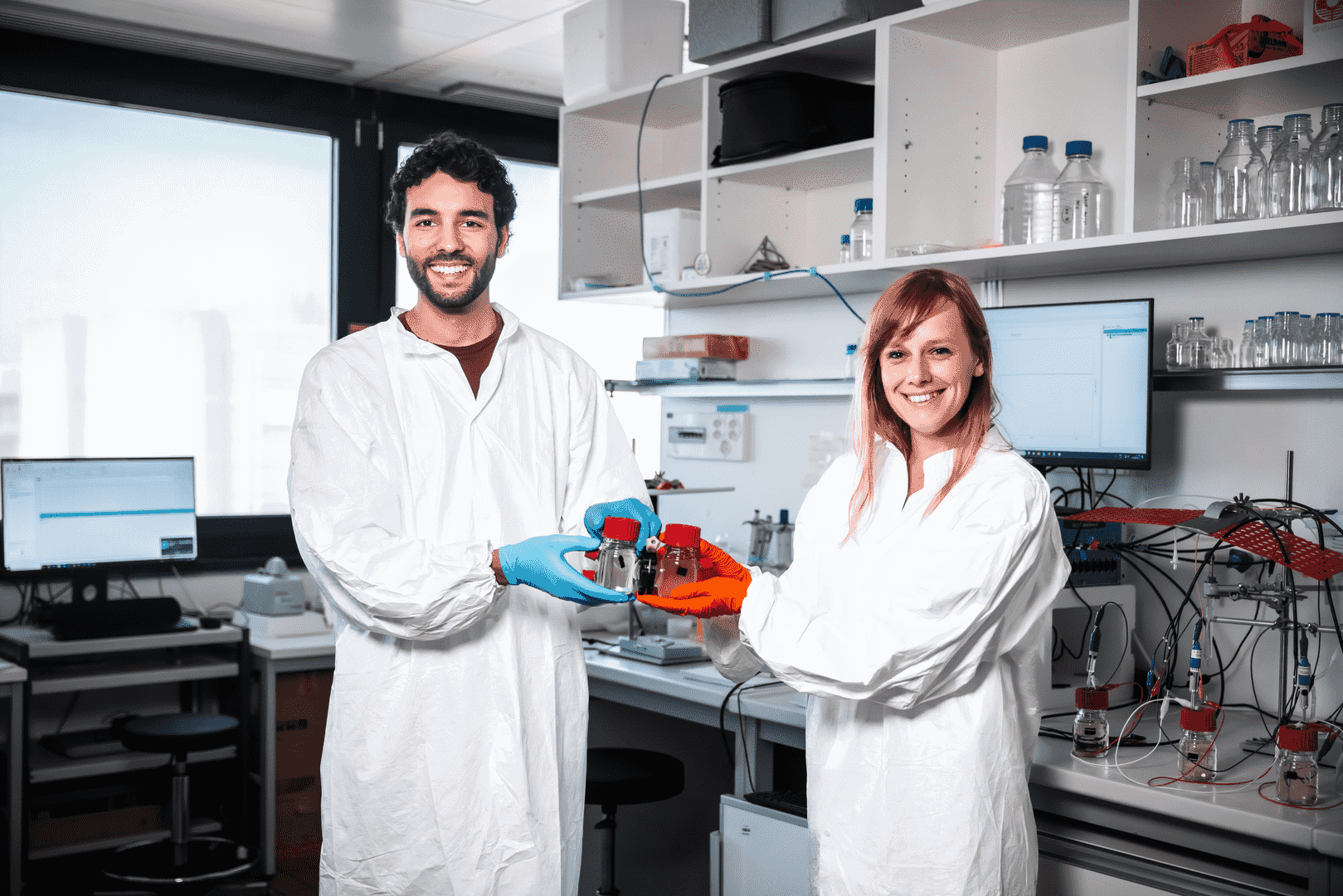

Een van de wetenschappers die aan het hoofd staan van de ‘markerloze’ aanpak is Mackenzie Mathis van de École polytechnique fédérale de Lausanne, de Technische Universiteit van Lausanne. Het laboratorium van deze jonge Amerikaanse neurowetenschapper heeft een vergaande software werkset ontwikkeld onder de naam DeepLabCut, die de bewegingen van dieren in realtime kan volgen en identificeren aan de hand van videobeelden.

DLC-Live! heeft lage latentie

Eerder deze maand presenteerde Mathis met collega’s van Harvard een nieuwe versie onder de naam DeepLabCut-Live! (DLC-Live!). Het artikel is in eLife, een wetenschappelijk open access tijdschrift voor bio- en biomedische wetenschappen, te lezen.

DLC-Live! wordt gekenmerkt door een zeer lage latentie. Binnen een 15.000ste van een seconde bij meer dan 100 FPS (beelden per seconde) komt neer op een zo goed als realtime bewegingsregistratie. DLC-Live! maakt gebruik van op maat gemaakte netwerken om de houding van dieren te voorspellen op basis van videobeelden (frames), met de mogelijkheid offline te komen tot 2500 FPS op een standaard grafische processor (GPU). Hiermee is DLC-Live! van grote waarde voor het bestuderen en onderzoeken van de neurale mechanismen van gedrag. Het kan worden gekoppeld aan laboratoriumhardware voor neurologische analyse. DLC-Live! is beschikbaar voor gebruik door onderzoekers (open source).

Het is vast ook een goed bericht voor de makers van (eventuele) nieuwe versies van ‘The Lion King’, ‘Flipper’ en ‘Lassie’.