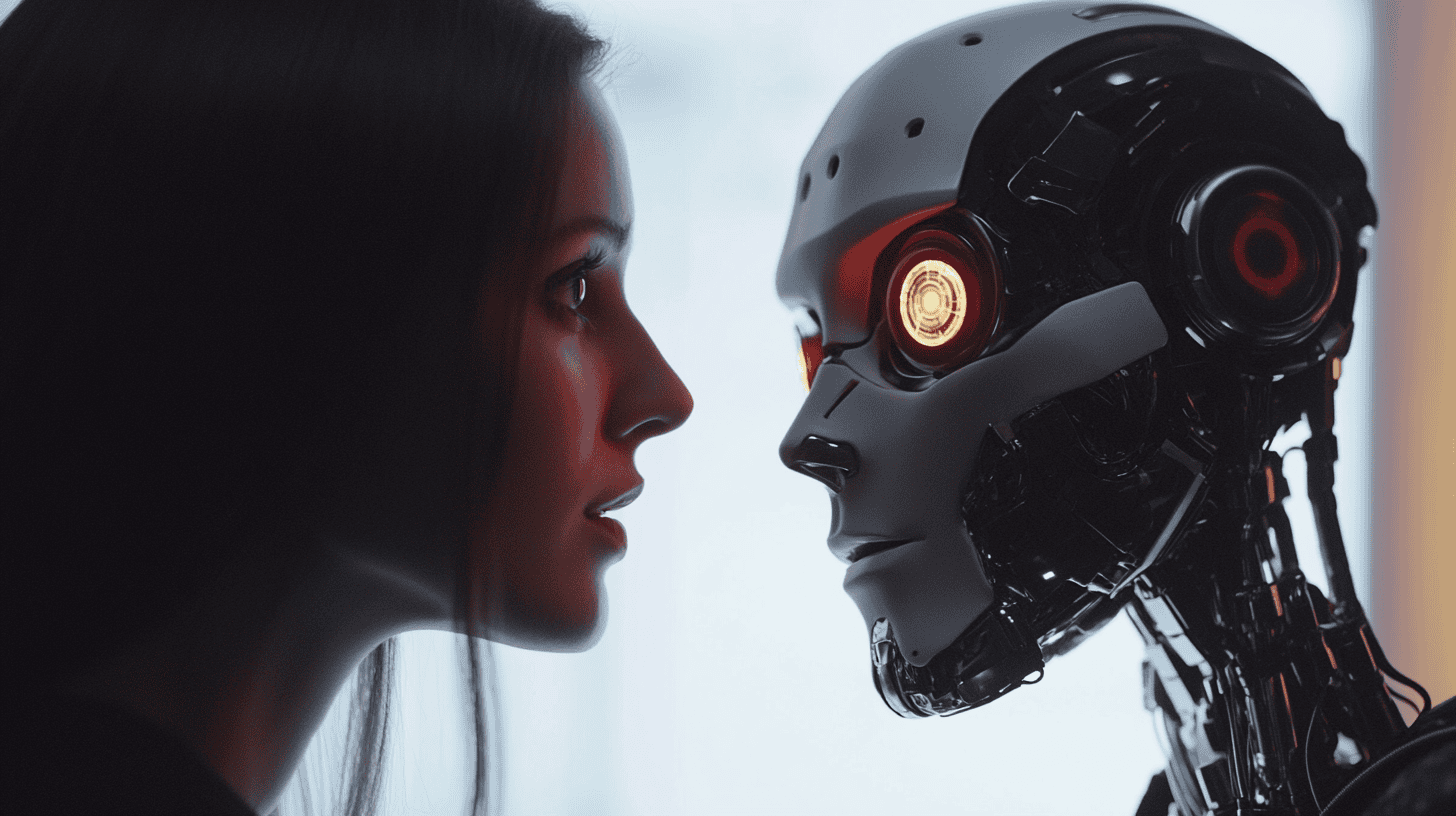

Navigeren door het online netwerk is bijzonder uitdagend geworden na de intrede van kunstmatige intelligentie. Sociale mediaplatforms worden overspoeld met desinformatie, waardoor gebruikers niet weten of bepaalde inhoud betrouwbaar is.

Waarom dit belangrijk is

De zogenaamde deep fake-beelden en -video’s hebben verkiezingen verstoord. Ook wekken ze bezorgdheid over de risico’s voor democratieën. Landen hebben hun wetgeving aangescherpt om desinformatie tegen te gaan. Volgens het 2024 Digital News Report maakt 59% van de ondervraagden zich zorgen over wat echt en wat nep is op internet.

Er is veel AI-gegenereerd materiaal, speciaal gemaakt om valse en schadelijke inhoud te verspreiden op sociale media. Is AI schuldig aan de opkomst van desinformatie?

Volgens Beatriz Farrugia, onderzoeksmedewerker bij het Digital Forensic Research Lab van de Atlantic Council en tevens professor, “zorgen AI-tools ervoor dat desinformatie zich nog sneller verspreidt dan eerder.”

Farrugia, die een expert is op het gebied van desinformatie en extremisme, zegt dat er momenteel geen onderzoeken zijn die daadwerkelijk bewijzen dat kunstmatige intelligentie leidt tot meer desinformatie. “Het is lastig om te meten, en als we dat zouden doen, zouden de resultaten beperkt zijn tot een bepaald land of omgeving, in een specifiek tijdsbestek.”

Geen nieuwe techniek

Al sinds het Romeinse Rijk wordt desinformatie gebruikt als wapen om verhalen te manipuleren. In die tijd was het de bedoeling om te zegevieren op het slagveld. Met de vooruitgang van kunstmatige intelligentie is het slagveld aangepast en momenteel is het einddoel om ontwrichting te veroorzaken:

“Desinformatiecampagnes zijn er altijd geweest. Wat nu verandert is de tactiek, de methode, de frequentie en de snelheid waarmee ze zich verspreiden,” legt Farrugia uit.

Sociale media in actie

De afgelopen jaren hebben sociale mediabedrijven hun platforms aangepast om de negatieve gevolgen van desinformatie tegen te gaan. Meta, TikTok, YouTube en X hebben nu content moderatie, waardoor gebruikers valse posts kunnen melden. Toch kunnen ze het niet volledig tegengaan. Tijdens de verkiezingen voor het Europees Parlement, eerder dit jaar, was een gecoördineerde desinformatiecampagne op X erop gericht om verkiezingsprocessen in Frankrijk, Duitsland en Italië te verstoren.

Nu is er een nieuwe component bijgekomen: AI-gegenereerde inhoud. Door een golf van samenzweringsverhalen en desinformatie op X en TikTok maken gebruikers zich zorgen over hoe ze online onderscheid kunnen maken tussen betrouwbare en onbetrouwbare content. Onlangs werden er nepverhalen en deepfakes gepost over de oorlog in Gaza en de Amerikaanse verkiezingen. Deze hadden miljoenen views.

Strengere regelgeving

Over de hele wereld leggen landen strengere regels op aan online platforms. In Brazilië heeft het Hooggerechtshof X van Elon Musk tijdelijk verboden. De reden: X had de deadline van de rechtbank niet gehaald om een wettelijke vertegenwoordiger in het land te benoemen.

Andere landen worden ook geconfronteerd met uitdagingen bij het reguleren van online platforms. De Europese Commissie heeft X, voorheen Twitter, aangeklaagd wegens overtredingen van de nieuwe Digital Services Act (DSA), bedoeld om desinformatie en illegale online inhoud terug te dringen. De Commissie beschuldigde X ervan niet genoeg te doen om de verspreiding van kwaadaardige inhoud op het platform tegen te gaan.

Verwarring over AI

De term “kunstmatige intelligentie” zorgt nog steeds voor verwarring onder mensen. Niet iedereen weet wat het betekent, welke mogelijkheden het biedt en hoe je AI-gegenereerde inhoud kunt herkennen.

Soms denken sociale mediagebruikers dat iets een ‘deep fake’ of ‘AI-generated’ is, terwijl de content legitiem is. Dit kan net zo schadelijk zijn als de content die door kunstmatige intelligentie zelf is gemaakt:

“In een verkiezingsscenario vormt deze verwarring een risico,” legt Farrugia uit. “In plaats van democratische discussies te versterken, wordt het informatie-ecosysteem gedestabiliseerd.”

In evenwicht

Technologiebedrijven zouden wettelijk verantwoordelijk moeten zijn voor het tegengaan van deze negatieve effecten. Toch ligt een groot deel van het probleem ook in de manier waarop mensen deze technologie gebruiken, met goede of kwade bedoelingen.

“We kunnen niet alleen de technologiebedrijven de schuld geven. We moeten ook de verantwoordelijkheid bij de maatschappij leggen,” zegt Farrugia. Ze legt uit dat er meer aandacht moet zijn voor de manier waarop deze tools worden ingezet en voor “de wetten die we nodig hebben om online misdaden te voorkomen”.

“Er is geen kant-en-klare oplossing voor het probleem.” Het kost veel tijd en moeite om een middenweg te vinden tussen AI, sociale mediaplatforms en de maatschappij. Toch is het essentieel om te werken aan mediageletterdheid, waarbij mensen leren hoe ze moeten navigeren in dit AI-netwerktijdperk. Gebruikers moeten leren om na te denken en weloverwogen beslissingen te nemen op basis van de inhoud die op sociale media wordt verzameld.

Verder moeten platforms zelf mechanismen, labels en categorieën creëren die aangeven welke inhoud door AI is gegenereerd. “Het is alsof je een nieuwe taal leert. Niemand zal het vloeiend leren in een paar lessen. Maar we moeten deze stappen nemen in het onderwijs.”

Mes snijdt aan twee kanten

Farrugia legt uit dat het ook mogelijk is om AI-tools te gebruiken, juist om desinformatie tegen te gaan. Zelf gebruikt ze kunstmatige intelligentie en taalmodellen om desinformatie en kwaadwillende actoren te detecteren.

“We verzamelen gegevens en gebruiken vervolgens AI om sneller patronen te analyseren en te vinden. Zo winnen we snelheid in de strijd tegen desinformatie”, zegt ze.