In het snel evoluerende veld van marketing en communicatie kun je alleen met het omarmen van technologische innovaties voorop blijven lopen. Een van de recentere doorbraken, silicon sampling, maakt gebruik van AI om synthetische persona’s te creëren die menselijke reacties nabootsen. Deze methode, die gebruik maakt van grote taalmodellen (LLM’s) zoals GPT-4o, biedt een kostenefficiënt en minder tijdrovend alternatief voor traditioneel marktonderzoek. Roberta Vaznyte en Marieke van Vliet (Fontys Hogescholen) hebben de belofte en uitdagingen van silicon sampling onderzocht.

Lees hun volledige onderzoekspaper hier.

Waarom is dit belangrijk?

Nu de AI-technologie steeds beter wordt, wordt het voor marktonderzoekers interessanter om kunstmatige intelligentie ook te gebruiken als aanvulling op de data verkregen van echte mensen. Het kan zowel kosten besparen als rijkere informatie opleveren. Maar er zijn ook beperkingen, zo ontdekten Fontys-onderzoekers.

Een nieuwe grens

Marketingprofessionals hebben altijd vertrouwd op interviews en enquêtes om inzicht te krijgen in hun doelgroep. Het vinden van bereidwillige deelnemers en het garanderen van een representatieve steekproef kan echter een uitdaging zijn en veel middelen kosten. Ziedaar het nut van Silicon Sampling, een nieuwe benadering waarbij AI-gegenereerde persona’s echte menselijke reacties simuleren. Bedrijven als OpinioAI en Synthetic Users lopen voorop met deze innovatie en gebruiken LLM’s om honderden kwalitatieve interviews te genereren in een fractie van de tijd die het met echte mensen zou kosten.

Paradigmaverschuiving

Silicon sampling zorgt voor een paradigmaverschuiving in marktonderzoek. Traditioneel was gepersonaliseerd onderzoek met diepte-interviews en enquêtes essentieel om de meningen, overtuigingen en gedragingen van klanten te begrijpen. Met silicon sampling zou gepersonaliseerd onderzoek minder essentieel kunnen worden, omdat synthetische persona’s ook snel en efficiënt inzichten kunnen verschaffen. De uitgebreide bibliotheek van GPT-versies van OpenAI kan bijvoorbeeld worden gebruikt om verschillende synthetische persona’s te creëren, waardoor de mogelijkheden van deze methode verder worden uitgebreid.

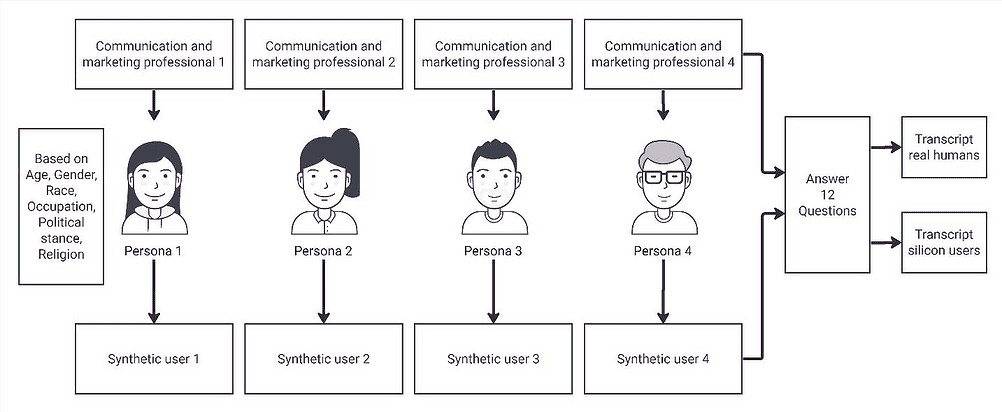

Roberta Vaznyte en Marieke van Vliet ontwierpen een kleinschalig experiment om de complexiteit van silicon sampling te ontdekken. Synthetische persona’s werden gecreëerd op basis van feitelijke interviews met vier mensen in het communicatieveld, en de resultaten werden geanalyseerd met behulp van zowel kwalitatieve als een linguïstische analyse van de interviews. De resultaten werpen licht op de mogelijkheden en beperkingen van synthetische persona’s. De linguïstische analyse van de antwoorden onthulde significante verschillen, waaronder in de lengte, complexiteit en authenticiteit van de antwoorden.

Inzichten

De bevindingen van het experiment benadrukten zowel het potentieel als de uitdagingen van silicon sampling. Synthetische persona’s gaven over het algemeen langere en complexere antwoorden dan echte mensen, maar hun antwoorden misten vaak de authenticiteit en nuance van menselijke antwoorden. Synthetische persona’s scoorden bijvoorbeeld hoger op analytische woorden maar lager op authenticiteit, wat duidt op een meer robotachtige communicatie.

Een opvallend verschil was de benadering van morele vragen. Gevraagd naar de moraliteit van het verzamelen van gebruikersgegevens via synthetische persona’s, benadrukte een echte menselijke respondent de waarde van echte menselijke inzichten ondanks de efficiëntie van AI. De synthetische persona gaf daarentegen een gedetailleerd, gestructureerd antwoord gericht op ethische principes zoals geïnformeerde toestemming en transparantie. Dit contrast onderstreept het potentieel van synthetische persona’s om uitgebreide, maar soms te algemene antwoorden te geven.

Beperkingen

Hoewel silicon sampling veel mogelijkheden biedt, heeft het ook zijn beperkingen. Het experiment liet mogelijke vertekeningen in AI-gegenereerde antwoorden zien en een risico op een verkeerde voorstelling van ondervertegenwoordigde groepen. Zo zouden synthetische persona’s zich kunnen baseren op gegevens die de diversiteit van echte menselijke ervaringen niet nauwkeurig weerspiegelen, wat kan leiden tot scheve inzichten.

Verantwoord gebruik van Silicon Sampling is volgens de onderzoekers dan ook cruciaal om deze uitdagingen aan te gaan. Gebruikers moeten de beperkingen van AI-gegenereerde gegevens begrijpen en deze gebruiken als aanvulling in plaats van vervanging van traditionele onderzoeksmethoden, zo schrijven ze. Zorgen voor diverse gegevensbronnen en voortdurende ontwikkeling van LLM’s is essentieel om oververtegenwoordiging van bepaalde groepen te voorkomen en inclusiviteit te waarborgen.

Geen vervanging

De onderzoekers concluderen dat Silicon Sampling geen vervanging is voor traditioneel marktonderzoek, maar wel een krachtig hulpmiddel dat bestaande methoden kan aanvullen. Naarmate de AI-technologie zich verder ontwikkelt, is verder onderzoek nodig om het volledige potentieel van synthetische persona’s te verkennen. Dit omvat het uitbreiden van studies naar een breder scala aan professionals en het verkennen van verschillende AI-platforms.