Augmented reality (AR) en virtual reality (VR) wordt steeds levensechter. Onlangs nog is een computerwetenschapper van de Universiteit van Saarbrücken erin geslaagd om virtuele beelden fysiek “tastbaar” te maken (zie IO-artikel hierover). Onderzoekers van de afdeling Vision and Imaging Technologies (VIT) van het Fraunhofer Heinrich Hertz Instituut HHI ontwikkelen nu nieuwe methoden om echte interactie met virtuele personages mogelijk te maken. Dat gebeurt met behulp van innovatieve volumetrische video’s.

Op dit moment zijn er slechts enkele studio’s in Europa die zich met deze technieken bezig houden. Een ervan is het in Eindhoven gevestigde bedrijf 4DRStudios .

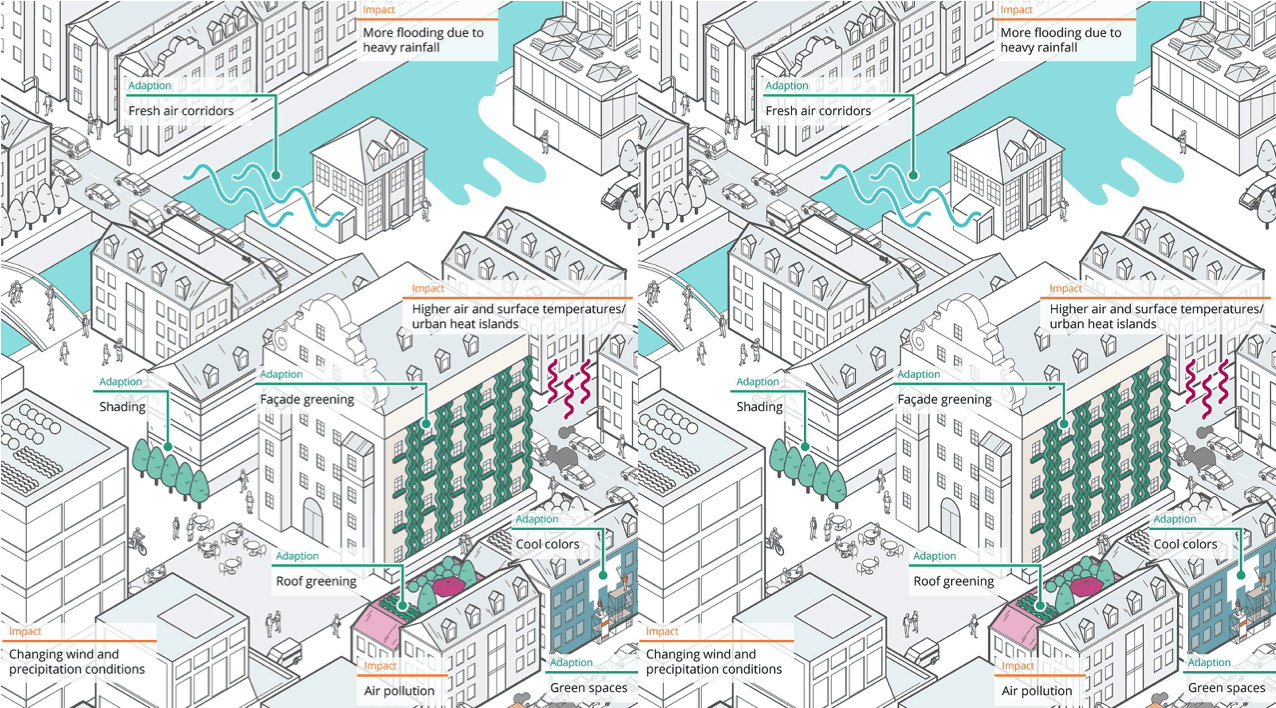

Augmented en virtual reality zijn ondenkbaar zonder volumetrische video. Dit komt omdat alleen deze methode een hoogwaardige “free-viewpoint rendering” van dynamische scènes mogelijk maakt. Rendering is het op basis van data met behulp van een computer beelden produceren. Tot nu toe ging het echter steeds om vooraf opgenomen scenes en beelden. Individuele interactie met de virtuele karakters was daarom niet mogelijk. “Om interactie mogelijk te maken worden meestal klassieke grafische computermodellen gebruikt. Maar deze bereiken niet hetzelfde niveau van realisme”, aldus de onderzoekers in een persbericht.

Dr. Anna Hilsmann, hoofd van de onderzoeksgroep Computer Vision en Graphics van de afdeling VIT, en haar collega’s hebben nu een methode gevonden om gegevens uit de echte wereld te te integreren in de virtuele wereld. Het proces wordt toegepast binnen het door de EU gefinancierde project “Innovative Volumetric Capture and Editing Tools for Ubiquitous Storytelling” (INVICTUS).

Levensechte VR-gezichten vormen een uitdaging

De belangrijkste kenmerken zijn “de toevoeging van semantiek en animatie-eigenschappen aan de vastgelegde gegevens en het gebruik van hybride geometrie- en video-gebaseerde animatiemethoden die directe animatie mogelijk maken”. Daarnaast is er ook een betrouwbare aanpak voor het verwerken van lichaamsbewegingen en gezichtsuitdrukkingen.

Vooral het weergeven van die gezichtsuitdrukkingen zijn een groot probleem voor de makers van Augmented en Virtual Reality. Hilsmann en haar collega’s stellen daarom een drietrapsoplossing voor in hun publicatie over hun methode in het speciale nummer “Computer Vision for the Creative Industry”. Allereerst wordt gebruik gemaakt van geometrie om kenmerken met een lage resolutie te modelleren, zoals grove motorieke bewegingen. Dan volgt de overlapping van op video gebaseerde texturen om subtiele bewegingen en fijne gelaatskenmerken vast te leggen. Als laatste worden dan subtiele details aangebracht, zoals de blik van de ogen; iets wat tot dusver eigenlijk altijd verwaarloosd werd.

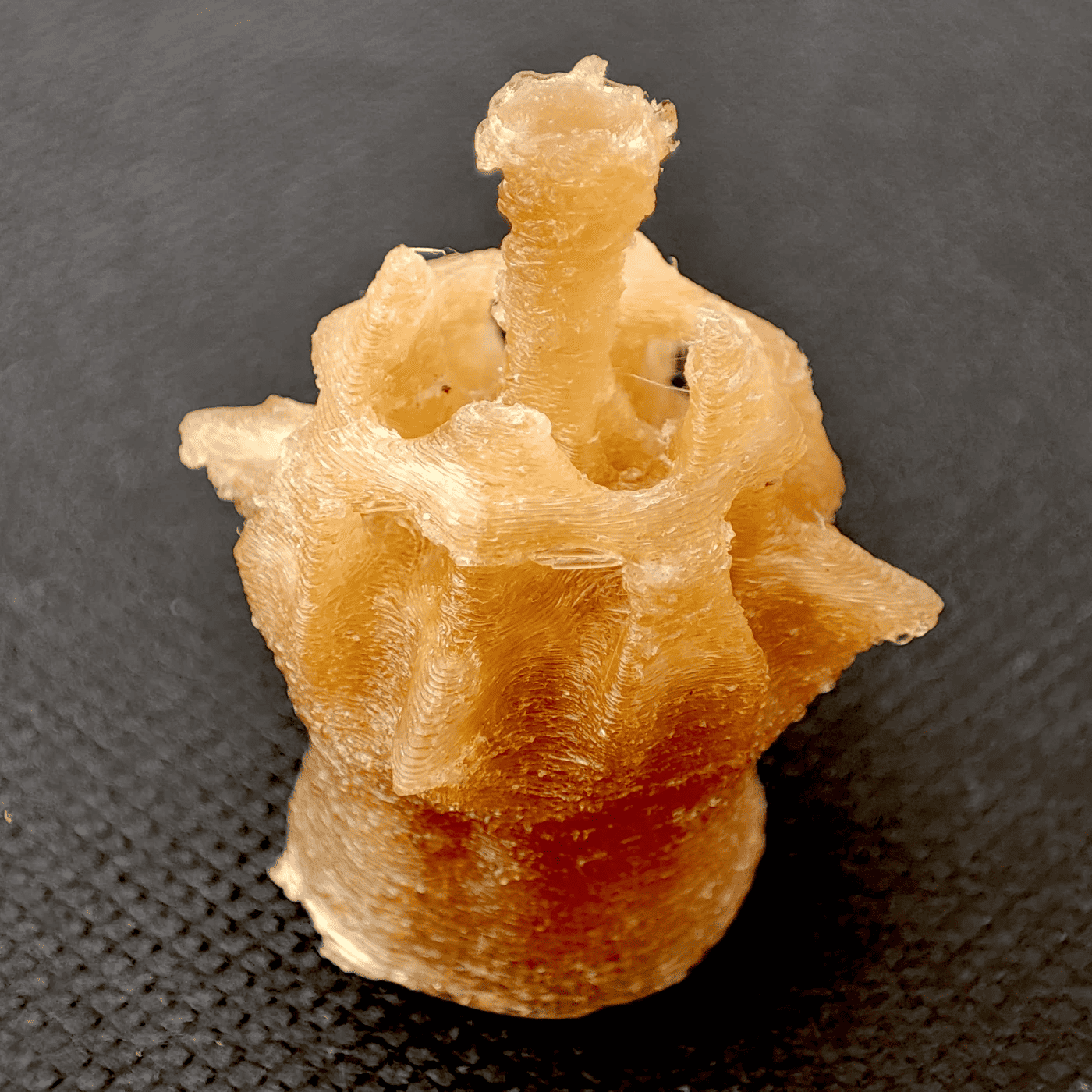

In het INVICTUS project zullen zowel het uiterlijk als de beweging van acteurs worden vastgelegd met behulp van state-of-the-art volumetrische motion capture technologieën. Daarmee kunnen dan volumetrische avatars worden gegenereerd.

Aan het einde van het project, dat sinds maart 2020 twee jaar loopt, zullen er volgens de onderzoekers onder andere drie innovatieve auteurshulpmiddelen beschikbaar zijn:

- één voor volumetrische opnames in hoge resolutie van het uiterlijk en de beweging van de acteurs. Dit kan dan gebruikt worden voor hoogwaardige offline producties (film) en real-time producties;

- een toepassing voor het bewerken van volumetrische verschijningen en bewegingen in hoge resolutie;

- een hulpmiddel voor het ontwerpen van de virtuele wereld. Dit omvat bijvoorbeeld het bewerken van decors, lay-outs en animatiefiguren.

Via deze link vindt u meer IO-artikelen over augmented reality.