About Immanence

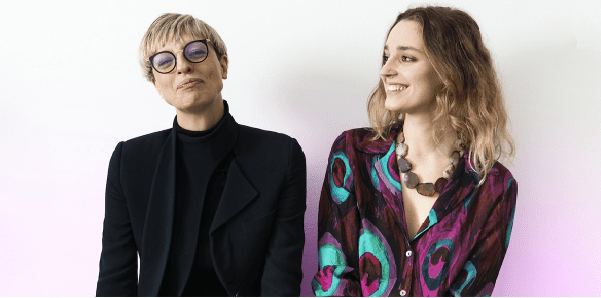

- Founders: Luna Bianchi, Dilletta Huyskes

- Founded in: 2023

- Employees: 2

- Money raised: -

- Ultimate goal: Sustaining tech companies making AI ethics accessible, modular, personalized and easy to plan to finally make business responsible of their impact, with ethics being a key performance indicator

Immanentie wordt gedefinieerd als “de toestand van aanwezig zijn als een natuurlijk en permanent onderdeel van iets”. En dat is hoe ethiek ruimte moet vinden in kunstmatige intelligentie, beweert Luna Bianchi, medeoprichter van het bedrijf dat als doel heeft bedrijven en overheden te helpen hun AI-systemen zo ethisch mogelijk te maken: Immanence. “Respectvol voor de mensen, respectvol voor wat hen omringt”, preciseert ze.

AI en AI-ethiek zijn het hete hangijzer van het jaar geworden. Sinds ChatGPT beschikbaar kwam voor het publiek, zijn er vragen gerezen: moet het op scholen worden gebruikt? Is het een gevaarlijke schepper van nepnieuws? De vragen zijn talrijk. Waarom, als je Midjourney vraagt om een dienstbode te tekenen, komt de software waarschijnlijk met het beeld van een niet-blanke vrouw? Het is belangrijk om deze vragen te stellen, maar het is ook belangrijk om te begrijpen dat dit specifieke kwesties zijn die voortkomen uit dezelfde wortel: AI versterkt menselijke vooroordelen, dus ook racisme en seksisme. Het feit dat de problemen dezelfde bron hebben, betekent echter niet dat de oplossing universeel is.

Iets meer dan een jaar geleden werd in Rome het concept Immanence geboren, dat een manier probeert te vinden om AI-systemen ethisch verantwoord te maken. Een van hun oprichters, Diletta Huyskes, had net een toespraak gehouden voor het Italiaanse Huis van Afgevaardigden. Het was 26 februari 2022, Luna Bianchi liep naar haar toe en ze bespraken het idee. Een jaar later zijn ze in business met Immanence. Innovation Origins sprak met Luna Bianchi, om hun missie te begrijpen.

Hoe werken jullie?

“We willen het idee veranderen dat de resultaten van technologie afhangen van hoe we ze gebruiken. Vandaag hangen ze eerder af van hoe we ze creëren. Daarom helpen wij bedrijven bij het opstellen van hun algoritmen. Je kunt ook later ingrijpen – we noemen het ‘ethisch onderhoud’ – maar voorkomen is beter dan genezen. Op dit moment is er niet veel wetgeving over AI-algoritmen. Internationaal is het vooral soft law en wordt het gezien als een checklist waaraan je moet voldoen, niet als iets fundamenteels.”

Het klinkt alsof Immanence een consultancybedrijf is, ook al heb je dit woord nooit gebruikt. Is dat zo?

“Als we het willen inkaderen in een type dienstverlening dat we gewend zijn, zouden we het eigenlijk consultancy moeten noemen. Maar ik hou niet zo van die term, omdat het lijkt alsof ik je vertel hoe je iets moet doen en dat ik alleen maar een probleem oplos dat je hebt. Wat wij doen is echter meer redeneren over dingen en potentiële problemen vinden waarvan ondernemers soms niet weten dat ze die hebben. Wij begeleiden en leggen uit, in plaats van alleen maar op te lossen. Wij creëren in het hoofd van de ondernemer een begrip van ethiek in technologie en waarom we die allemaal nodig hebben. Dus ja, technisch gezien is het een consultancy bureau. Maar ik denk dat een correctere term ‘co-design’ is.”

Wat is de methode die jullie volgen?

“We volgen bedrijven vanaf het begin van hun ontwikkeling. We praten graag met de verschillende afdelingen van het bedrijf om te begrijpen wat ieders prioriteit is. Wat de praktische aspecten betreft, vragen sommige bedrijven gewoon om een ethische beoordeling, en dat is – om terug te komen op de vorige vraag – heel vergelijkbaar met een adviesbureau. Maar het grootste deel van ons werk bestaat uit het bieden van een optie aan bedrijven om hun AI-ethiekontwikkeling uit te besteden. Wij verzorgen dat op continue basis zolang het bedrijf dat wil. En we beoordelen de situatie telkens als er iets verandert. Zoals wanneer het bedrijf meldingen krijgt van gebruikers, als ze het algoritme veranderen, of als ze iemand nieuw aannemen voor een bepaalde functie. Er komt een EU-wet aan, en we proberen daarop te anticiperen. Op dit moment kan ik niet veel zeggen over specifieke kwesties, omdat we net met al onze projecten beginnen. In alle gevallen herzien onze experts het algoritme en bepalen zij of dat het juiste soort is dat het bedrijf moet gebruiken. Dan beredeneren we welk AI-model het beste zou kunnen werken. Soms gaan mensen bijvoorbeeld voor machine learning zonder er al te veel over na te denken. Maar ze hebben het niet per se nodig, en dat betekent dat ze meer moeite moeten doen om het onder controle te houden dan met een ander model. We onderzoeken ook wie het algoritme heeft ontwikkeld, wie het heeft getest, en – natuurlijk – we nemen datasets door om er zeker van te zijn dat ze eerlijk zijn voor mensen. We willen er zeker van zijn dat we alle potentiële problemen evalueren, samen met oplossingen en gevolgen.”

Je zei dat er een veel voorkomende misvatting is over AI-ethiek, welke?

“We hebben allemaal de neiging om over AI-ethiek te denken als iets algemeens. Alsof het one-size-fits-all altijd toepasbare principes zijn. En dat is tot op zekere hoogte waar. Wat we echter vergeten is hoezeer AI afhankelijk is van de context en menselijke input, en hoe snel deze wereld beweegt. De systemen veranderen, de context verandert en het geweten van mensen verandert. Daarom kun je niet vertrouwen op vaste formules, maar moet je voortdurend controleren en je aanpassen. Ethiek moet in AI aanwezig zijn als een natuurlijk onderdeel ervan. Daarom hebben we ons bedrijf ‘Immanence’ genoemd.”