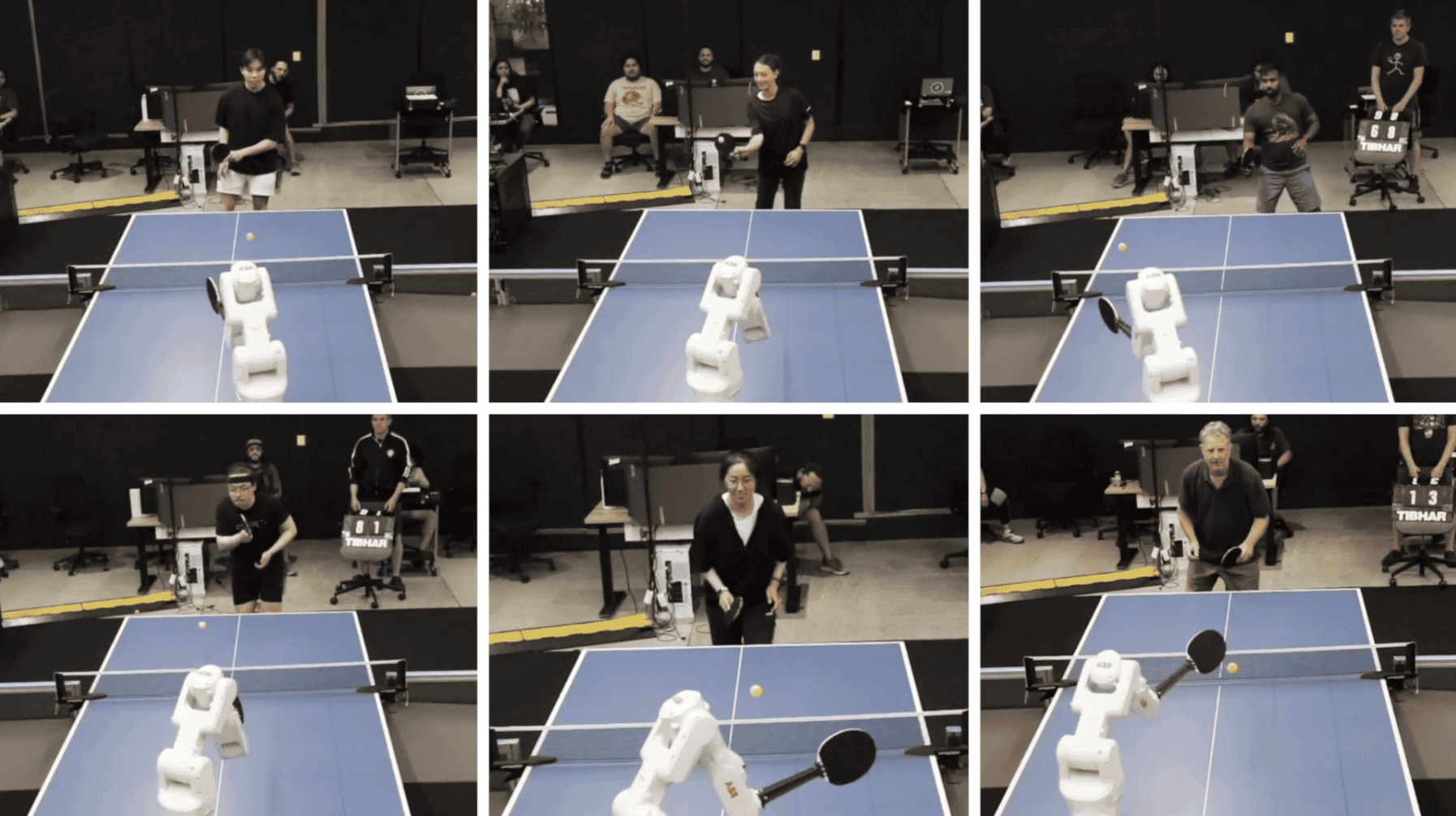

Google DeepMind’s nieuwste creatie slaat hard toe in de tafeltenniswereld. Deze robotarm, getraind met een mix van simulaties en echte data, verslaat moeiteloos beginners en geeft zelfs 55% van de amateurs het nakijken. Met 13 overwinningen in 29 wedstrijden past de AI-speler razendsnel zijn tactiek aan. Hoewel topspelers nog niet verslagen zijn, is het voor de meeste menselijke tegenstanders nu al onmogelijk het van de machine te winnen. De robot worstelt nog met snelle ballen en kan niet serveren, maar dat is vast een kwestie van tijd. Ook met schaak en Go lukte het Deepmind niet direct om de wereldkampioen te verslaan.

Met ‘AlphaPong‘ slaagt een robot er voor het eerst in om op menselijk niveau een fysieke sport te spelen. Met behulp van een ABB IRB 1100 industriële robotarm en aangepaste AI-software, is deze robot in staat om op amateur-niveau te concurreren met menselijke spelers.

Training en data

De training van ‘AlphaPong’ was een combinatie van computersimulaties en echte data. De AI leerde in een gesimuleerde fysica-omgeving gebaseerd op 17.500 real-world baltrajecten en verfijnde zijn vaardigheden met gegevens van meer dan 14.000 rallyballen en 3.000 services. Dit hybride trainingsprogramma stelde de robot in staat om zich aan te passen aan verschillende speelstijlen en -niveaus zonder specifieke training per speler.

In tests won de robot 45% van de 29 gespeelde wedstrijden, waaronder alle wedstrijden tegen beginners en 55% tegen middelsterke spelers. Echter, tegen gevorderde spelers verloor de robot alle wedstrijden. De robot heeft nog steeds moeite met snelle, hoge of lage ballen en kan de spin van de bal niet direct meten, wat een beperking vormt tegen meer ervaren tegenstanders.