Voor wie nog aan het bijkomen is van wat Midjourney en Dall-E’s AI-ondersteunde beeldgeneratie ons hebben gebracht, is er verontrustend nieuws: we hebben de grenzen van de kunstmatige intelligentie nog lang niet bereikt. Het vermogen van AI-tools om beelden te manipuleren blijft groeien. Het laatste voorbeeld is te vinden in een onderzoeksartikel van het Max Planck Instituut. Voorlopig is het “slechts” een onderzoeksdocument, maar wel een zeer indrukwekkend document, dat toont hoe gebruikers elementen van een foto kunnen verslepen om hun uiterlijk te veranderen.

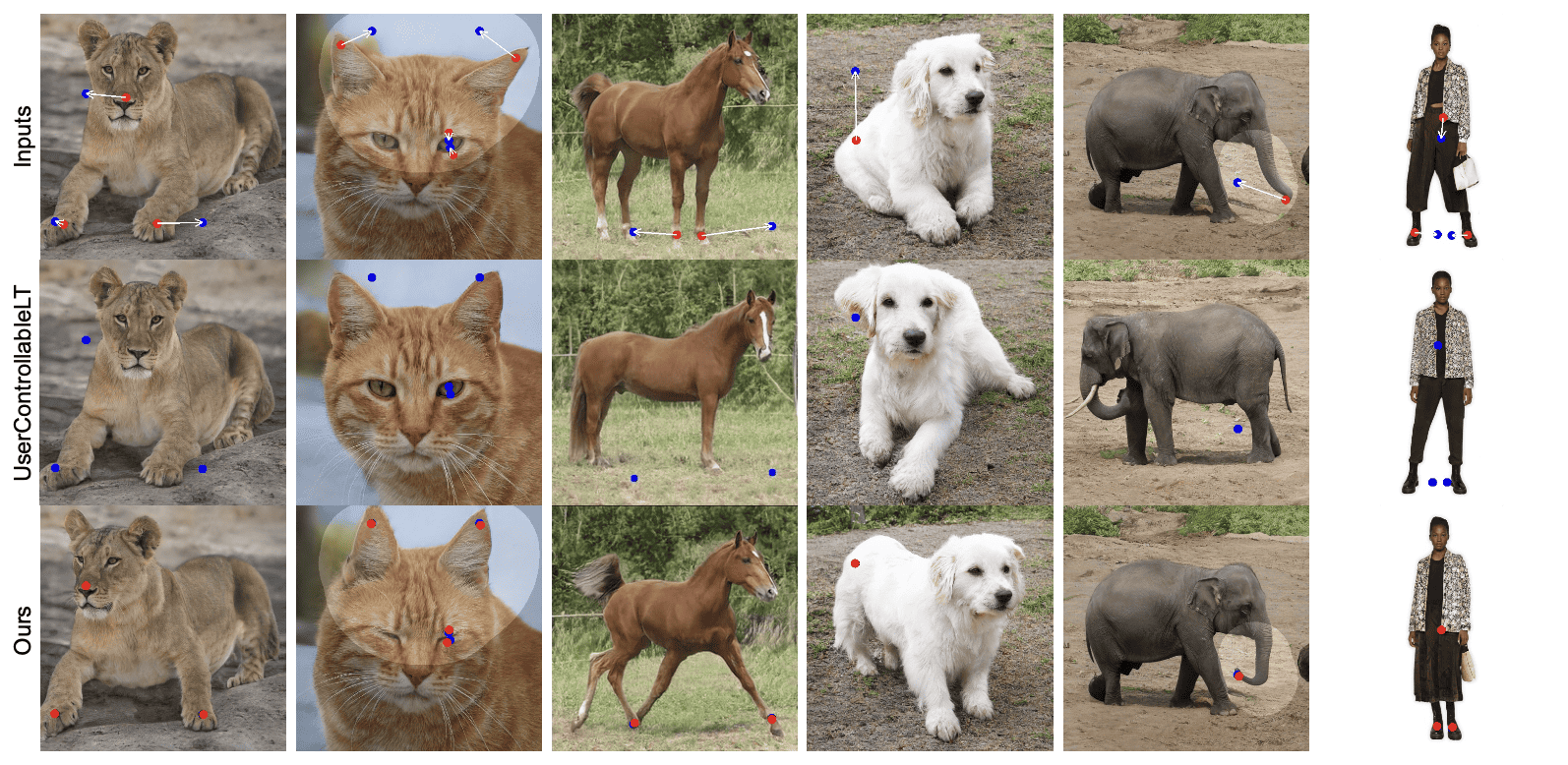

Als je het nog niet snapt, hier is een voorbeeld:

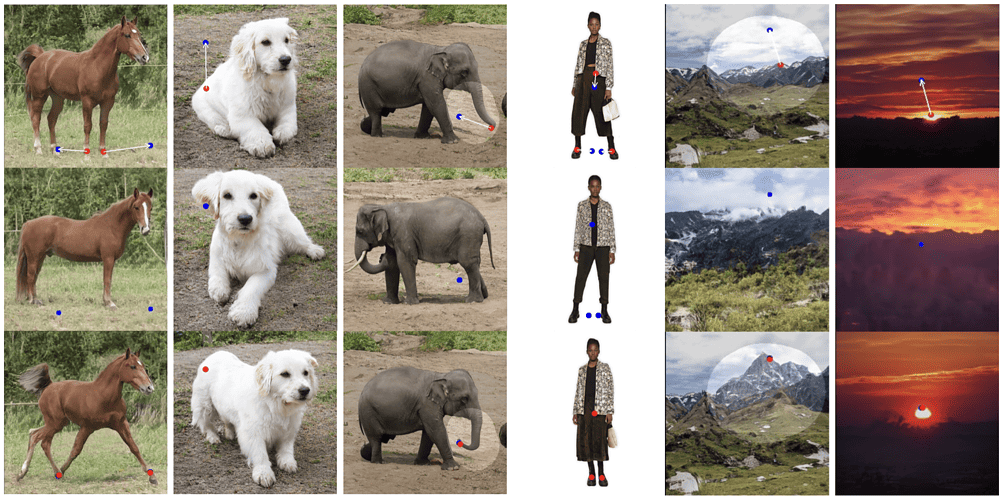

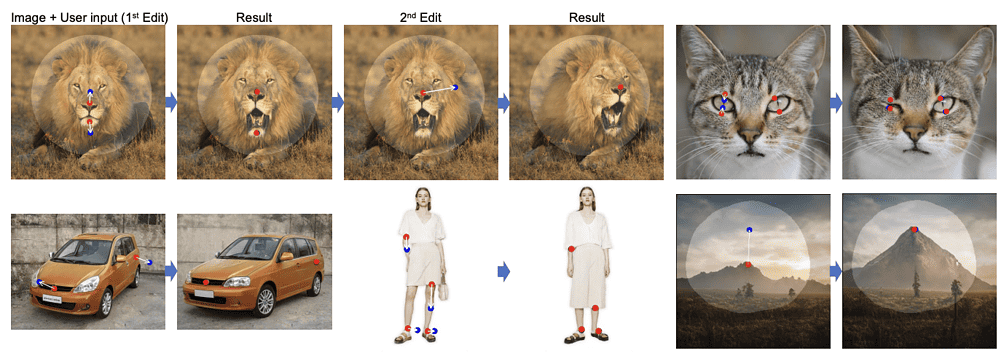

Je kunt niet alleen de afmetingen van een auto veranderen of een glimlach veranderen in een frons met een simpele klik en sleep, maar je kunt het onderwerp van een foto roteren alsof het een 3D-model is – en zo bijvoorbeeld de richting veranderen waarin iemand kijkt. Een andere mogelijkheid is om met een paar klikken de reflecties op een meer of de hoogte van een berg aan te passen.

DragGAN

Om visuele content te maken die voldoet aan de behoeften van de gebruiker is vaak precieze en flexibele controle nodig over attributen als houding, vorm, expressie en lay-out van de gegenereerde objecten. Traditionele methoden voor het aansturen van Generative Adversarial Networks (GANs) zijn afhankelijk van handmatig geannoteerde gegevens of eerdere 3D-modellen. Deze benaderingen missen echter vaak precisie, flexibiliteit en een generieke aanpak. Als antwoord op deze tekortkomingen introduceert het Max Planck Instituut DragGAN, een nieuwe aanpak waarmee gebruikers interactief punten in een afbeelding naar bepaalde locaties kunnen “slepen”.

DragGAN bestaat uit twee hoofdcomponenten: een op kenmerken gebaseerde bewegingscontrole en een nieuwe benadering voor het volgen van punten. De bewegingssupervisie maakt het mogelijk om handvatpunten in het beeld te verplaatsen naar doelposities. De point-tracking aanpak maakt gebruik van onderscheidende generator kenmerken om de locaties van de handgreeppunten bij te houden als ze worden verplaatst. Daardoor kunnen gebruikers beelden met precisie vervormen en attributen zoals houding, vorm, expressie en lay-out beïnvloeden in verschillende categorieën zoals dieren, auto’s, mensen en landschappen.

Flexibel en nauwkeurig

Deze methode biedt een meer flexibele, precieze en generieke manier om GAN’s aan te sturen, waarbij gebruikers een willekeurig aantal handvatpunten en overeenkomstige doelpunten op een beeld kunnen selecteren. Het doel is deze handvatpunten te verplaatsen om hun respectieve doelen te bereiken. Met deze aanpak kan de gebruiker een reeks ruimtelijke attributen controleren, ongeacht de objectcategorieën. Dit onderscheidt DragGAN van eerdere methoden die vaak niet generaliseren naar nieuwe objectcategorieën of beperkte controle bieden over ruimtelijke attributen.

De aanpak van DragGAN is niet afhankelijk van andere netwerken zoals RAFT, waardoor het efficiënt is voor manipulatietaken. De onderzoekers beweren dat het in de meeste gevallen slechts enkele seconden duurt op een RTX 3090 GPU. Dit maakt live, interactieve bewerkingssessies mogelijk, waardoor snelle iteratie van verschillende lay-outs mogelijk is tot de gewenste output is bereikt.

Door een uitgebreide evaluatie van diverse datasets heeft DragGAN aangetoond dat het in staat is door de gebruiker gedefinieerde handvatpunten naar doellocaties te verplaatsen, waardoor diverse manipulatie-effecten in vele objectcategorieën kunnen worden bereikt. Een belangrijk kenmerk van DragGAN is dat de gebruiker een binair masker kan invoeren, dat het beweegbare gebied in een afbeelding aangeeft. Dit maakt een meer genuanceerde controle van manipulaties mogelijk, waardoor ambiguïteit wordt verminderd en bepaalde gebieden gefixeerd blijven.

Beperkingen en misbruik

De onderzoekers waarschuwen echter ook dat DragGAN zijn beperkingen heeft. Hoewel het enige extrapolatiemogelijkheden bezit, kan de kwaliteit van de bewerking nog steeds worden beïnvloed door de diversiteit van de trainingsgegevens. Bovendien hebben handvatpunten in textuurloze gebieden soms last van drift bij het volgen. Ondanks deze beperkingen biedt DragGAN een effectieve, interactieve benadering van beeldbewerking.

De auteurs van het artikel wijzen ook op de mogelijkheid van misbruik van de technologie, aangezien deze kan worden gebruikt om beelden van een echt persoon met een valse houding, uitdrukking of vorm te creëren. Zij benadrukken het belang van het respecteren van persoonlijkheidsrechten en privacyregels bij elke toepassing van hun benadering.

DragGAN zou een aanzienlijke vooruitgang kunnen betekenen op het gebied van GAN-gebaseerde beeldmanipulatie. De methode maakt gebruik van een vooraf getraind GAN om beelden te genereren die de invoer van de gebruiker nauwkeurig volgen en toch realistisch blijven. Door het gebruik van een optimalisatie van latente codes en een point tracking procedure, biedt DragGAN pixel-precieze beeldvervormingen en interactieve prestaties. De auteurs hopen deze puntgebaseerde bewerking in de toekomst uit te breiden naar 3D generatieve modellen.