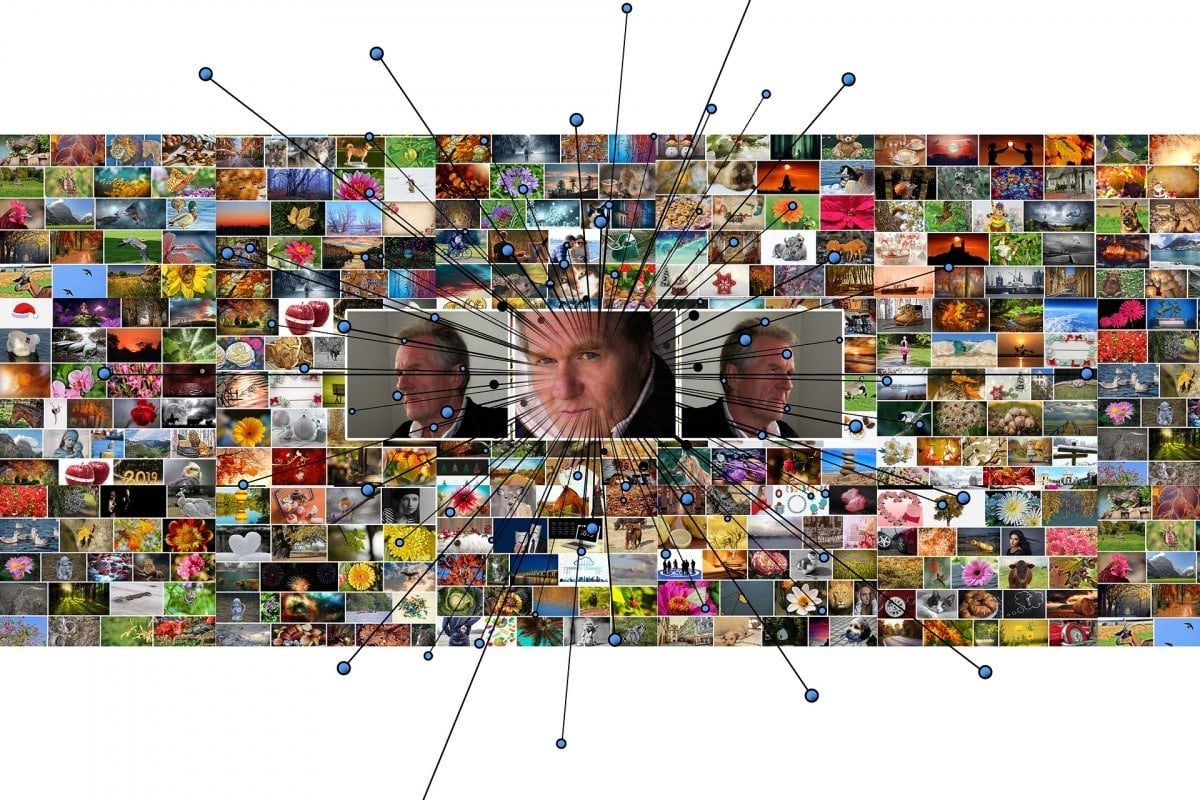

De afgelopen weken was er veel aandacht voor het nieuws dat de overheid algoritmes gebruikt om fraude en criminaliteit op te sporen. Gefeliciteerd! zou ik zeggen, we hebben een overheid die efficiënter wordt en met haar tijd meegaat. Het bericht dat de overheid nog steeds geen gebruik maakt van voorspellende algoritmes, zou veel verontrustender zijn.

Maar in de media werd dit gegeven vanuit een heel ander perspectief belicht. Zo publiceerde NOS het artikel “Overheid gebruikt op grote schaal algoritmes, ‘risico op discriminatie”, waarin de stelling werd geponeerd dat het gebruik van voorspellende algoritmes een groot risico op discriminatie met zich meebrengt. Dit artikel leidde tot verontwaardigde reacties van lezers, en maakte duidelijk dat de discussie over het gebruik van algoritmes voor een belangrijk deel geleid wordt door emoties. Daarmee werd voorbij gegaan aan het feit dat de titel van het artikel op zijn zachtst gezegd tendentieus, maar feitelijk gezien ook onjuist is.

Beter en sneller dan mensen

De letterlijke betekenis van het woord discriminatie is ‘het maken van onderscheid’. En dat is precies wat een algoritme doet. Het classificeert data op basis van verwantschap in kenmerken. En het doet dat veel beter en sneller dan dat mensen dat kunnen. Maar als je uitgaat van de letterlijke betekenis van het woord discriminatie, is de stelling dat het gebruik van voorspellende algoritmes een groot risico op discriminatie met zich meebrengt, onzinnig. Je zou dan moeten stellen ‘Algoritmes discrimineren, daar zijn ze voor gemaakt’.

Maar in maatschappelijke context staat discriminatie voor iets heel anders. Daar gaat het over onrechtmatig onderscheid maken (op basis van zaken als geslacht, religie, overtuiging, geaardheid etc.). En dat is nou precies wat een algoritme nìét doet. Een algoritme produceert bij dezelfde input steeds dezelfde output. Het is amoreel en kan dus per definitie geen onrechtmatig onderscheid maken. Populair gezegd; een algoritme is niet onderhevig aan een nacht weinig slaap of aan een vervelende ervaring met de benedenbuurman. Mensen zijn dat wel. Toch is de verwarring begrijpelijk. Een algoritme wordt gemaakt – en leert – aan de hand van data. En daar ligt de moeilijkheid. Data blijken niet vrij van menselijke invloed en kunnen op veel manieren ‘biased’ zijn. Het kan dus wel degelijk voorkomen dat er aspecten in data verborgen liggen, die leiden tot discriminatie.

Eenvoudig te ontdekken

Dus net zoals discriminerende aspecten verborgen kunnen liggen in het menselijke proces, kunnen deze verborgen liggen in data. Het grote verschil is echter dat discriminatie in het menselijk proces erg moeilijk te ontdekken en te corrigeren is; zo leert ons de geschiedenis. Discriminatie in data daarentegen blijkt relatief eenvoudig te ontdekken, en bovendien een heel stuk makkelijker te corrigeren. Daar kunnen algoritmes aan bijdragen.

Vandaar dat ik, uitgaande van de maatschappelijke betekenis van het woord discriminatie, de volgende stelling zou willen poneren: Algoritmes discrimineren niet. Mits door mensen gecontroleerd, kunnen ze bijdragen aan een samenleving waarin iedereen in gelijke gevallen, gelijk wordt behandeld.

“Allen die zich in Nederland bevinden, worden in gelijke gevallen gelijk behandeld. Discriminatie wegens godsdienst, levensovertuiging, politieke gezindheid, ras, geslacht of op welke grond dan ook, is niet toegestaan.” (artikel 1, Grondwet)

Over deze column:

In een wekelijkse column, afwisselend geschreven door Maarten Steinbuch, Mary Fiers, Peter de Kock, Eveline van Zeeland, Lucien Engelen, Tessie Hartjes, Jan Wouters, Katleen Gabriels en Auke Hoekstra, probeert Innovation Origins uit te vinden hoe de toekomst eruit zal zien. Deze columnisten, af en toe aangevuld met gastbloggers, zijn allemaal op hun eigen manier bezig met oplossingen voor de problemen van onze tijd. Zodat Morgen Beter wordt. Hier alle eerdere afleveringen.