Even aan Siri vragen om een reminder in je telefoon te zetten terwijl Netflix je films voorschotelt op basis van eerdere keuzes. Of je thermostaat warmt de woonkamer alvast op als je vertrekt van je werk. Allemaal relatief onschuldige voorbeelden van het gebruik van artificial intelligence. In de zorg wordt AI intussen gebruikt voor het herkennen van tumoren op CT-scans of voor een virtuele verpleegkundige zoals Molly. In de financiële sector doen creditcardmaatschappijen fraudechecks en ook gebruiken banken algortitmes om te bepalen of iemand een lening kan krijgen. AI is overal.

AI werkt niet zonder data, wat gebeurt er met al deze gegevens? Zijn gemeentes vrij om alle data die ze over jou verzamelen zomaar te gebruiken? In dit verhaal zochten we het uit.

Hoe moeten we hier mee omgaan? Moeten we het gewoon laten gebeuren of een grens trekken? En als dat gebeurt, wie stelt deze grens dan? En wie houdt er toezicht op alle nieuwe dingen die worden gemaakt?

Microsoft

In een blogpost van Brad Smit, de president van Microsoft en hoofd legal, pleit hij voor regels en wetten voor gezichtsherkenningstechnologie. Volgens de Microsoft hoofdman heeft deze technologie allerlei gevaren. Van bias -vooringenomenheid- van algoritmes tot het schenden van privacy of overheden die iedere burger in de gaten kunnen houden. Het wordt volgens hem hoog tijd dat overheden zich hiermee bezig gaan houden.

De Europese Unie

De Europese Unie heeft een groep van 52 experts, mensen uit allerlei sectoren, die advies moeten geven hoe regelgeving rond artificial intelligence eruit moet komen te zien. Sinds december zijn ze hiermee bezig geweest en de eerste versie van de richtlijnen voor betrouwbare AI is af. Het gaat hier om ethische dilemma’s waar al tijdens het ontwerpproces aandacht voor moet zijn. Er staan dingen in als: mensen moeten voorop staan, er moet speciale aandacht zijn voor kwetsbare groepen en minderheden. Ook situaties waarin er ongelijkheid van macht of beschikking van informatie voor kan komen, zoals contacten tussen bedrijven en consumenten of werknemers. Ook moet er volgens dit document meer aandacht zijn voor de controle op kunstmatige intelligentie via een controlelijst achteraf. Maar omdat het zo’n veranderend onderwerp is, mag het niet zo zijn dat er vakjes worden afgevinkt. De definitieve versie van deze richtlijnen moet in maart af zijn.

ISO

“Het is ongelooflijk belangrijk dat we met zijn allen dezelfde taal spreken”, zegt Jana Lingenfelder. Zij werkt naast IBM voor ISO aan een standaard voor AI. De International Standardisation Organisation (ISO) is een organisatie waar internationale standaarden worden ontwikkeld voor allerlei markten en industriën. “Een internationale standaard waarin iedereen gebruik maakt van dezelfde definities en basisregels waar ontwerpers en bedrijven op kunnen teruggrijpen. AI gaat verder dan nationale grenzen, daarom is het ook goed dat de EU hiermee bezig is en richtlijnen opstelt.”

Jan Schallaböck, advocaat in Duitsland, richt zich vooral op privacy. Hij denkt bij ISO mee aan een standaard voor onder andere techbedrijven, waar ze in een zo vroeg mogelijk stadium van hun product of dienst al bezig moeten zijn met de privacy van de gebruiker.

Hij sluit zich bij Lingenfelder aan, maar hij ziet problemen voor het naleven van die regels: “Kunstmatige intelligentie goed in de gaten houden kost tijd, veel overheden of andere toezichtsorganen hebben deze capaciteit niet. Bovendien, in hoeverre zijn zij in staat om in te schatten hoe een algoritme een beslissing neemt? Dat is voor heel veel experts al een hele klus. Dan heb je het nog niet eens gehad over de verantwoordelijkheid en aansprakelijkheid. Komt die bij de gebruikers te liggen? Bij de platforms? Of de mensen die AI ontwikkelen? En hoe zorg je ervoor dat een algoritme een ethische beslissing maakt?”

Ethisch of cijfers?

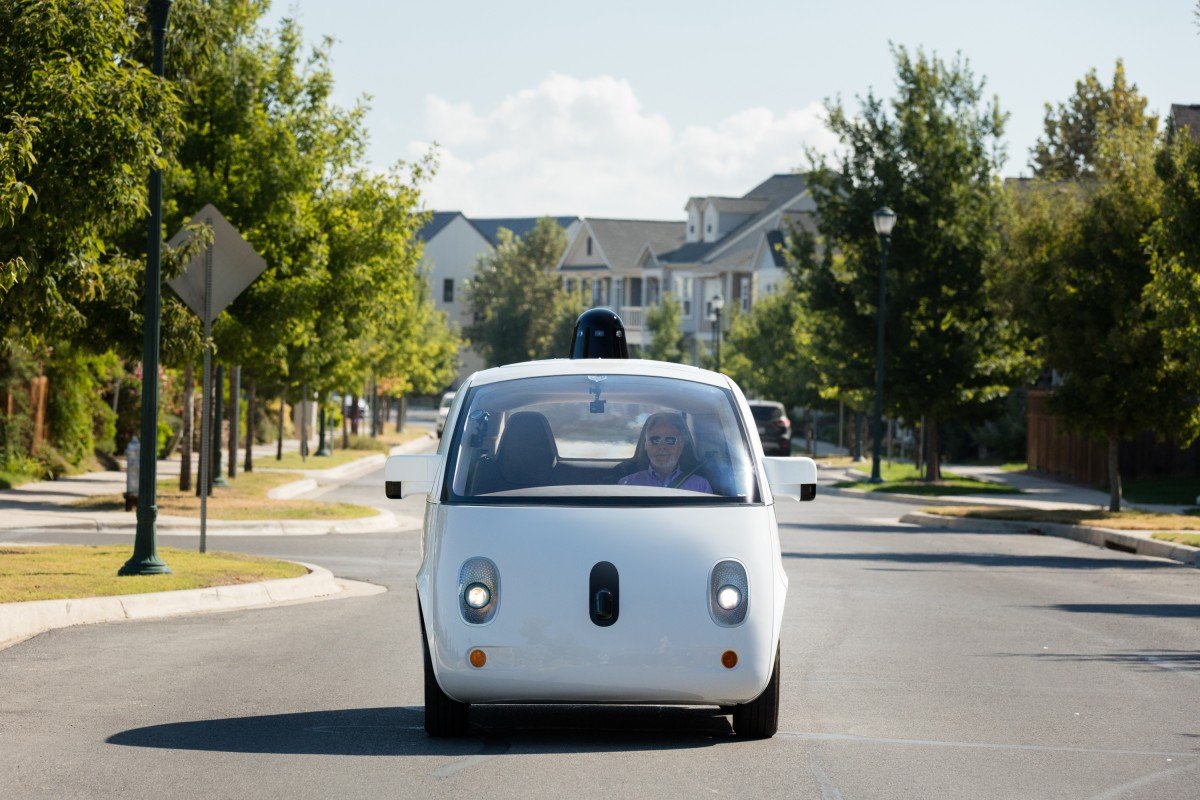

Een zelfrijdende auto die tijdens een botsing moet kiezen om een fietser of een voetganger te raken. Zulke dingen moeten worden ingebouwd worden in systemen. Volgens Christian Wagner zit hier een veel gemaakte denkfout. Kunstmatige intelligentie kan helemaal geen ethische beslissingen maken. Wagner geeft les aan de Universiteit van Nottingham en is directeur van LUCID, waar ze zich bezighouden met onderzoek om uncertain data beter te kunnen begrijpen, vastleggen en redeneren. Er wordt volgens hem vaak gesproken over strong AI, waar de techniek net als de mens kan oordelen over goed en fout. “Maar zo ver zijn we nog lang niet. We moeten er allereerst voor zorgen dat systemen stabiel zijn. Een zelfrijdende auto mag niet ineens onverwachte dingen doen. Dat gaat met getallen en kansberekeningen.”

Wel denkt hij dat het goed is om standaarden en richtlijnen op te stellen, maar hij twijfelt of zo’n model houdbaar is: “De techniek gaat erg hard en om iedere keer een nieuw model te ontwerpen is erg lastig. Moet je dan ook iedere keer een nieuw model voor toezichthouders maken?” Ook Schallaböck vindt dit een lastige: “Standaarden zoals de ISO maakt, zijn altijd goed, maar moet je dan voor iedere toepassing van AI een nieuwe standaard gaan maken? Deze procedures zijn tijdrovend en erg duur.”

Dan speelt er nog de vraag wie die toezichthouders zijn, want zoals Lingenfelder ook al ziet, gaat AI verder dan lokale grenzen en heeft het internationaal impact op alle niveau’s van de samenleving. De drie hebben hier nog geen duidelijk antwoord op. Misschien een nog op te richten EU-orgaan dat toeziet op naleving van de regels? Schallaböck: “We hebben nu de GDPR, maar dat is lang niet genoeg. We hebben nog geen antwoord op de gevaren die AI met zich meebrengt. Het is niet alleen een gevaar voor de democratie, maar ook voor de rechten van individuele personen.”

Foto: Waymo